GPUサーバーとは?失敗しない選び方、導入メリットから最新機種まで

GPUサーバーは、AIモデルの学習や大規模データ解析を飛躍的に高速化し、処理時間を 「数週間 → 数時間・数日」 に短縮できる強力なインフラです。その結果、開発コストや人的リソースを大幅に節約しながら、高度なAIサービスや解析基盤を実現できます。

本記事では、GPUサーバーがビジネスに与えるメリット、用途別の選び方、導入時の注意点、さらには最新GPUサーバー機種までをわかりやすく解説します。

【この記事でわかること】

・GPUサーバーの基本:CPUサーバーとの根本的な違い

・ビジネス上のメリット:なぜ今、GPUサーバーが注目されるのか

・失敗しない選び方:クラウドとオンプレはどちらが良い?予算や用途に合わせた選定方法

・導入事例:GPUサーバーで成果を上げた企業の具体例

・専門家によるサポート:最適な導入を実現する方法

目次

こんな課題はありませんか?AI・データ活用の壁となる「計算リソース問題」

多くの企業がAIやデータ活用の重要性を認識しながらも、そのポテンシャルを最大限に引き出せずにいます。その最大の原因の一つが、計算リソースの不足です。

・AIの学習モデルを一度回すのに数週間かかり、試行錯誤ができない

・高解像度の3Dレンダリングやシミュレーションが終わらず、プロジェクトが遅延する

・数テラバイト級のビッグデータを分析しようにも、結果が出るのを待つ間に日が暮れる

・VDI(仮想デスクトップ)環境で、グラフィックを多用するCADソフトの動作が遅く、生産性が上がらない

これらの課題は、従来のCPUを中心としたサーバーでは解決が困難です。ここで、解決の鍵となるのが「GPUサーバー」です。

「GPUサーバー」とは?CPUサーバーとの根本的な違い

GPUサーバーとは、その名の通りGPU(Graphics Processing Unit)を搭載したサーバーのことです。

もともとGPUは、PCゲームなどの画像処理を専門に行う半導体でした。しかし、その構造的な特性が科学技術計算やAIのディープラーニングに応用できることが分かり、現在ではデータセンターに不可欠な存在となっています。

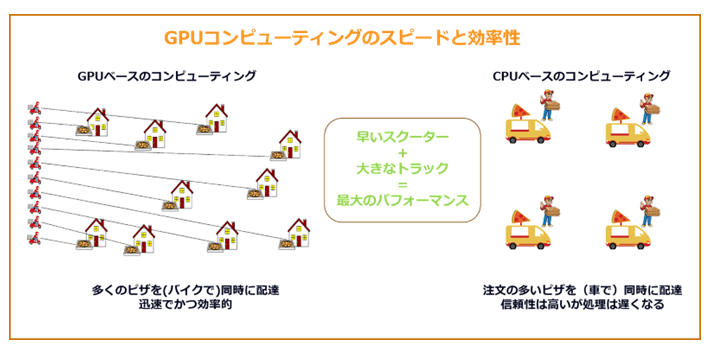

CPUサーバーとの違いを理解するために、よく使われる例えがあります。

CPU(中央処理装置):複雑で連続的な処理が得意な「万能な少数精鋭の職人」

GPU(画像処理装置):単純な計算を同時に数千個単位でこなせる「単純作業が得意な大軍勢」

AIのディープラーニングや大規模なシミュレーションでは、膨大な量の単純な計算(行列演算)を同時に行う必要があります。これは、少数精鋭のCPUよりも、大軍勢であるGPUが圧倒的に得意とする領域です。

この「並列処理能力」こそが、GPUサーバーが計算時間を劇的に短縮できる理由です。

| 項目 | GPUサーバー | CPUサーバー |

|---|---|---|

| 主な構成要素 | GPU(Graphics Processing Unit) | CPU(Central Processing Unit) |

| 得意な処理 | 同時に大量の単純な計算(並列処理) | 複雑で順序が重要な処理(直列処理) |

| 特徴的な構造 | 数千~数万の演算コアを持ち、大量のタスクを並列に実行 | 少数の高性能コアで多様なタスクを順番に処理 |

| 代表的な用途 | AI(ディープラーニング)、機械学習、画像・映像解析、科学技術計算 | Webサーバー、データベース、業務アプリケーション処理 |

| 処理スピードの傾向 | 並列演算が中心のタスクで圧倒的に高速 | 一般的な業務処理では安定したパフォーマンス |

| 導入コスト | 高価だが特定分野では高い費用対効果を発揮 | 比較的安価で汎用性が高い |

| 消費電力・発熱量 | 高負荷時に消費電力が大きく、発熱も多い | 比較的省電力で安定稼働しやすい |

| 向いているユーザー・企業 | AI開発・データ解析・研究開発など高演算処理が必要な企業 | 一般的な業務処理や中小規模のWebサービス運用企業 |

ビジネスを加速させるGPUサーバーの3大メリット

GPUサーバーの導入は単に「計算が速くなる」だけではなく、ビジネス全体に大きなインパクトをもたらす多くのメリットがあります。

ここではGPUサーバー導入のメリットについてご紹介します。

メリット1:開発・解析時間を短縮し、市場競争力を高める

AIモデルの開発やデータ解析において、数週間かかっていた処理が数日、あるいは数時間に短縮されるケースも珍しくありません。

これにより、製品開発のサイクルが高速化し、他社に先駆けてサービスを市場に投入することが可能になります。

メリット2:コストパフォーマンスの最適化(TCO削減)

GPUサーバーは高価ですが、エンジニアや研究者の「待ち時間」という最も高価なコストを削減できます。

開発期間の短縮は人件費の削減に直結し、結果的にTCO(総所有コスト)の削減に繋がります。

メリット3:新たなビジネス価値とイノベーションの創出

これまで時間やコストの制約で不可能だった規模の分析や、より複雑なAIモデルの構築が可能になります。

これにより、新たな顧客インサイトの発見や、革新的なサービスの開発など、データ主導のイノベーションが生まれやすくなります。

GPUサーバーの主な用途

GPUサーバーは、幅広い現場で活用されています。

| 用途 | 活用シーン・目的 | GPUサーバー導入による効果 |

|---|---|---|

| ① AI / 機械学習 | AIモデルの学習、画像認識、自然言語処理など | 大量データを高速に並列処理し、学習時間を大幅に短縮。より高精度なモデル開発を実現。 |

| ② 仮想デスクトップ(VDI) | リモートワーク、複数ユーザーによる同時作業 | GPUの高速描画性能により、操作の遅延を防ぎ、快適な仮想環境を提供。 |

| ③ 研究開発分野 | 生命科学(ゲノム解析)、気象モデリング、物理シミュレーションなど | 複雑な数値計算やシミュレーションを高速処理し、研究効率を大幅に向上。 |

| ④ 3Dレンダリング | 映像制作、ゲーム開発、建築・製品デザインなど | 高品質な3D画像・映像をスムーズに生成し、制作時間を短縮。 |

| ⑤ ビッグデータ解析 | 大規模データの解析、マーケティング分析、金融リスク分析など | 膨大なデータを短時間で分析し、新たなパターン発見や迅速な意思決定を支援。 |

ここでは、中でも代表的な5つの用途について、詳しく確認していきましょう。

用途①:AI / 機械学習

近年大きな話題を集めるAI開発や機械学習では、大量のデータを高速に処理することが求められます。その際、GPUサーバーを利用すれば、並列処理能力を大幅に向上させられます。そのため、さまざまなAI開発、機械学習のアルゴリズムに活用されています。

用途②:仮想デスクトップ

GPUサーバーは、仮想デスクトップで作業をする際にもよく使われます。仮想デスクトップは、複数の作業を並行して同時に行うために使われますが、その効率性や快適性はGPUの処理速度に大きく依存します。GPUサーバーを利用すれば、複数人でリモート作業したとしても、スムーズに作業を進められるでしょう。

用途③:研究開発

GPUサーバーは、研究開発の現場でも役立っています。たとえば、生命科学(ゲノム)の解析や、気象モデリングなどでは、複雑な計算が必要となりますが、GPUサーバーがあれば、正確な結果をスムーズに得られるでしょう。

用途④:3Dレンダリング

GPUサーバーは、映像やゲーム、建築デザインの制作などで使われる3Dレンダリングにも活用されています。GPUサーバーがあれば、高品質な画像や映像がスムーズに生成できるので、大規模なプロジェクトであっても、効率的に作業を進められるでしょう。

用途⑤:ビッグデータ解析

ビッグデータ解析とは、テラバイトやペタバイト級の膨大で多様なデータ群から、ビジネスに有益なパターンや相関関係を見つけ出すプロセスです。従来のシステムでは処理に膨大な時間を要しましたが、GPUサーバーの圧倒的な並列処理能力を用いることで、解析時間を劇的に短縮できます。これにより、迅速な意思決定や、これまで不可能だった複雑な分析からの新たな知見の発見を可能にし、企業の競争力を高めます。

【重要】失敗しないGPUサーバーの選び方 3つのステップ

ここからは、自社に最適なGPUサーバーを導入するための具体的な3つのステップを解説します。この順番で検討を進めることが、導入の失敗を防ぐ鍵となります。

Step 1:導入形態を決める ~「オンプレミス」 vs. 「クラウド」

最初に決めるべきは、自社内にサーバーを設置する「オンプレミス」か、インターネット経由で利用する「クラウド」か、です。それぞれにメリット・デメリットがあり、どちらが優れているというものではありません。自社の状況に合わせて選択しましょう。

| 比較項目 | オンプレミス | クラウド |

|---|---|---|

| 初期コスト | 高額(ハードウェア購入費) | 低い(基本的には不要) |

| 運用コスト | 変動(電気代、設置場所代、人件費) | 従量課金(使った分だけ発生) |

| パフォーマンス | 専有できるため、安定・高性能 | ベストエフォートが多く、性能が変動する場合がある |

| セキュリティ | 自社ポリシーで柔軟に構築可能 | ベンダーのセキュリティ基準に依存 |

| カスタマイズ性 | 高い(自由に構成可能) | 低い(提供されるメニューの範囲内) |

| こんな企業に推奨 | 高度なセキュリティ要件や、常に安定した高性能が必要な研究開発部門。長期的に利用する場合。 | スモールスタートしたいスタートアップ。利用量に繁閑の差が激しいプロジェクト。 |

Step 2:用途と予算からメーカー・製品シリーズを選ぶ

導入形態が決まったら、具体的なメーカーと製品シリーズを検討します。 特にAI・ディープラーニングの分野においては、ソフトウェアエコシステム(CUDA)が充実しているNVIDIA社がデファクトスタンダードとなっており、ほとんどのケースで第一候補となるでしょう。

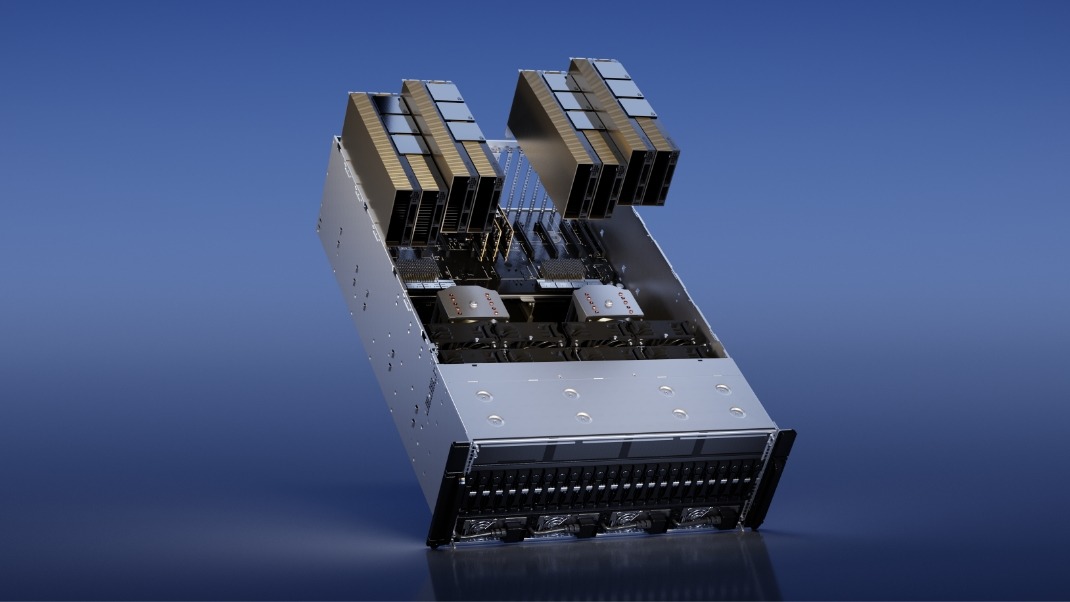

そのNVIDIA社が提供するソリューションの中でも、エンタープライズ向けに最適化された「NVIDIA DGXシリーズ」は、ハードウェア、ソフトウェア、サポートが一体となったプラットフォームであり、AI開発基盤の構築において最高峰の性能と信頼性を発揮します。

Step 3:詳細なスペックを詰める

最後に、具体的なハードウェアのスペックを決定します。

スペック検討の際のポイントは主に以下の6つです。

GPUの性能

AIモデルのサイズや扱うデータ量に直結するVRAM(ビデオメモリ)容量が最も重要です。予算の許す限り、大容量のモデルを選んでおくと将来的に対応できる幅が広がります。

サーバーの形状

データセンターのラックに収める「ラックマウント型」と、オフィスにも設置可能な静音性に優れた「タワー型(ワークステーション)」があります。

サーバーの拡張性

GPUサーバーの拡張性は、将来的なニーズの変化に対応できるかどうかを判断する上で重要な要素です。

拡張性の高いサーバーは、メモリ、ストレージ、GPUなどを増設できるため、必要に応じて性能を向上させることができます。

特に、AI開発や機械学習などの分野では、データ量や計算処理の複雑さが日々増しているため、拡張性の高いサーバーを選ぶことが重要です。

冷却性能

GPUサーバーは、高負荷な計算処理を行うため、発熱量が大きいという特徴があります。

そのため、冷却性能の高いサーバーを選ぶことが重要です。

冷却性能が低いと、サーバーが熱暴走を起こし、故障や性能低下の原因となります。

冷却方式には、空冷、水冷などがあり、サーバーの設置環境や用途に合わせて適切な方式を選ぶ必要があります。

消費電力

GPUサーバーの消費電力は、運用コストに大きく影響します。

特に、24時間365日稼働させる場合は、消費電力の低いサーバーを選ぶことで、電気代を大幅に削減できます。

GPUの性能と消費電力はトレードオフの関係にあるため、性能と消費電力のバランスを考慮して選ぶことが重要です。

ソフトウェアの互換性

GPUサーバーを利用する上で、ソフトウェアの互換性は非常に重要な要素です。

使用するソフトウェアがGPUサーバーに対応しているかどうかを事前に確認する必要があります。

特に、AI開発や機械学習などの分野では、特定のGPUアーキテクチャに最適化されたソフトウェアが多いため、注意が必要です。

GPUサーバーに搭載されている代表的なGPU

GPUサーバーで利用される代表的なGPUについてご紹介します。

| GPU | アーキテクチャ/特徴 | メモリ容量 | メモリ帯域幅 | 仕様(消費電力など) |

|---|---|---|---|---|

| RTX 6000 | プロフェッショナル向け GPU、Ada Lovelace アーキテクチャ | 48 GB GDDR6(ECC対応) | 960 GB/s | 最大消費電力 300 W、アクティブ冷却、PCIe 4.0 ×16、vGPU サポートあり。 |

| B300 | Blackwell Ultra GPU を搭載し、トレーニングと推論を同一プラットフォームで高性能に処理可能な「AIファクトリー」用途向けシステム。 | 2.3 TB | 推論:144 PFLOPS(FP4) トレーニング:72 PFLOPS(FP8) |

消費電力概ね約 14 kW(ラック/システム構成による)。 |

| HGX B200 | 最新 Blackwell ベースのサーバ/AI クラスボード構成。大規模モデル学習・推論用途向け。 | 180 GB HBM3E | 7.7 TB/s (GPU 間 NVLink/NVSwitch による 1.8 TB/s バンド幅、合計 14.4 TB/s インターコネクト) |

TDP(熱設計電力)最大 1,000W 構成可能。NVLink 第5世代、MIG 7 分割対応。 |

| H200 | データセンター向け高性能モデル。生成AIおよびHPCワークロード向け。HBM3eメモリ搭載。 | 141 GB | 4.8 TB/s | TDP(熱設計電力)Up to 700 W(SXM構成)/Up to 600 W(NVL構成)。 |

| H100 | 高性能コンピューティングや大規模AIモデル向け。H100 Tensor コア GPU。MIG(Multi-Instance GPU)対応。 | 80 GB(HBM2e)などモデルにより異なる仕様あり。 | 約 2 TB/s(構成により異なる)。 | 高消費電力。複数GPUを接続する NVLink Switch システム対応など拡張性あり。 |

| L40 | ビジュアルコンピューティングに強いモデル。Ada Lovelace アーキテクチャ。セキュリティ機能(Secure Bootなど)対応。 | 48 GB GDDR6 | 864 GB/s | 最大消費電力 300 W。NVLink非対応。MIG非対応。補助電源等条件あり。 |

| L4 | ユニバーサルアクセラレータ寄り。映像処理/仮想化/軽量AI用途向け。Ada Lovelace アーキテクチャ。 | 24 GB GDDR6 | 300 GB/s | 最大消費電力 約 72 W。補助電源不要のモデルあり。 |

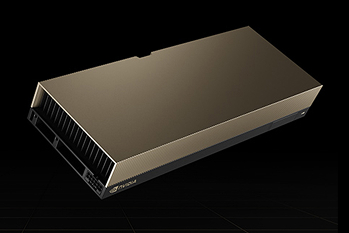

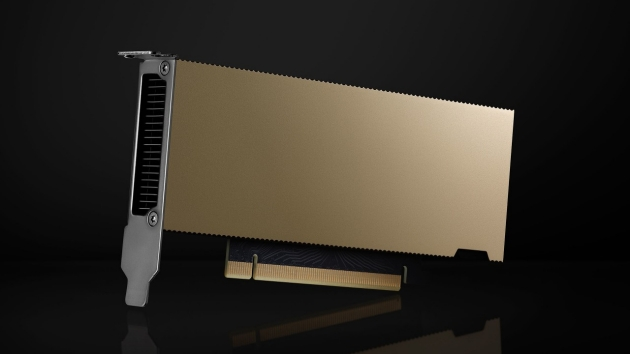

NVIDIA RTX 6000 Ada

NVIDIA RTX 6000 Adaは、最新のAda Lovelaceアーキテクチャを採用した高性能グラフィックスカードです。

48GBのGDDR6メモリを搭載しており、大規模なデータセットや複雑なシミュレーションにも対応可能です。また、18,176基のCUDAコアを備えており、高度な並列処理能力を提供します。

NVIDIA HGX B200 Tensor Core GPU製品の詳細はこちら

NVIDIA RTX 6000 Adaについては以下の記事でも詳しくご紹介しています。

NVIDIA RTX 6000 Ada 世代グラフィックス カードとは?製品の特徴を紹介

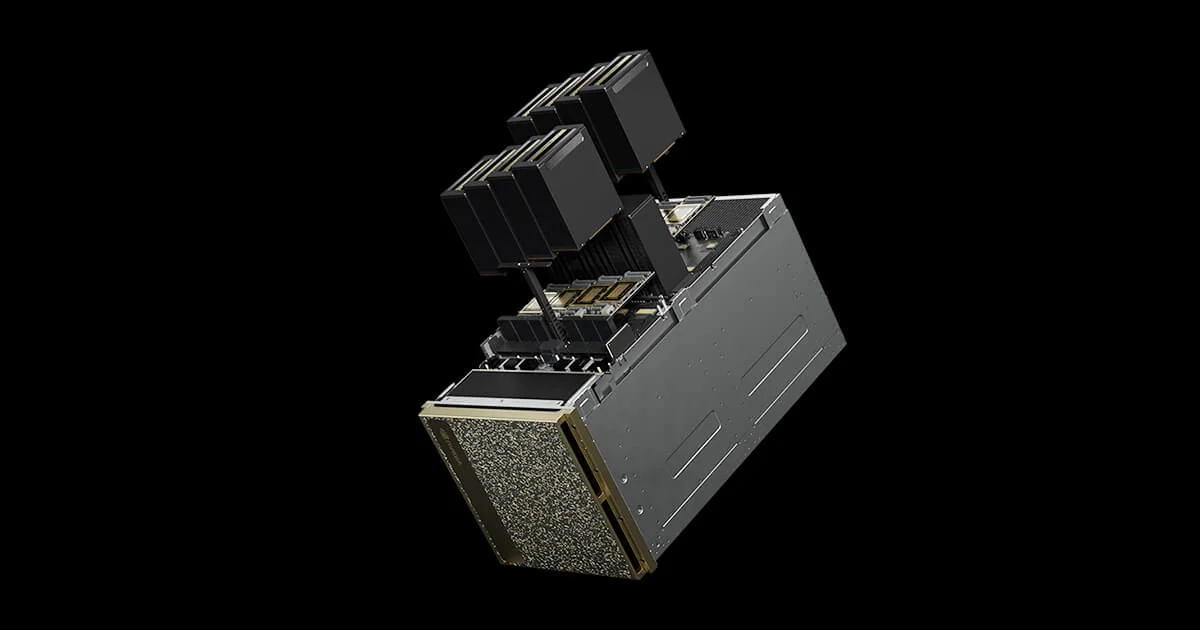

NVIDIA B300 GPU

NVIDIA HGX B300は、Blackwell Ultra GPUと最新のNVLinkやInfiniBandを組み合わせた次世代プラットフォームです。 前世代比で推論性能が最大11倍に向上し、生成AI、大規模データ解析、HPCといった高負荷処理に最適です。 スケールアップとスケールアウトの両構成に対応し、次世代データセンター基盤を支えます。

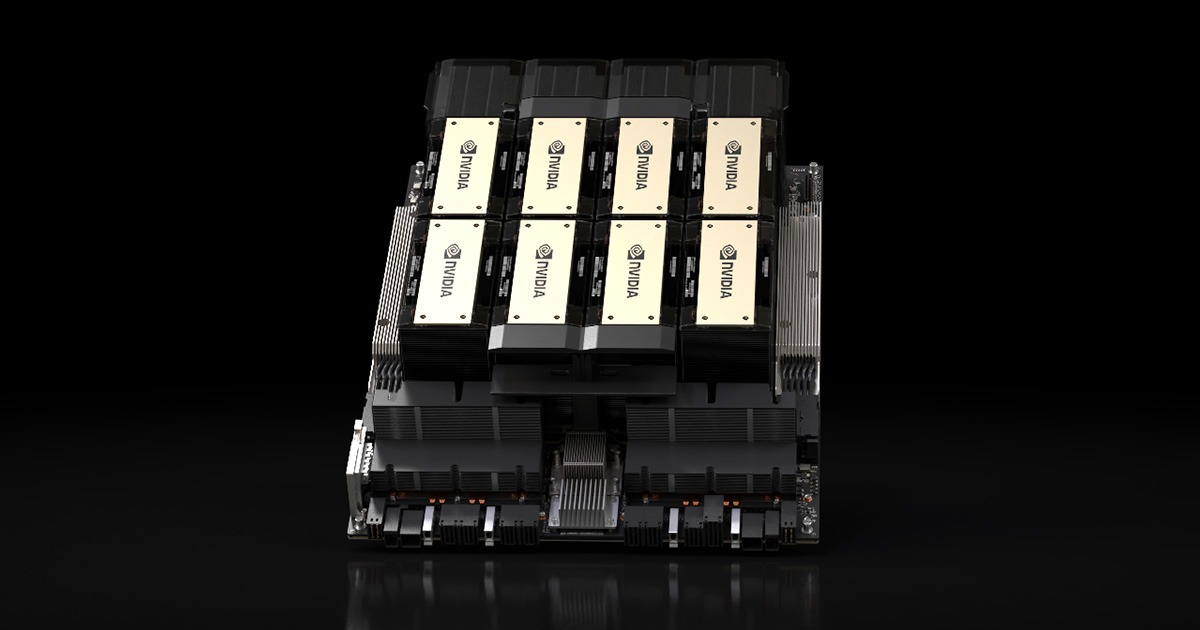

NVIDIA B200 GPU

NVIDIA B200は、データセンター向けの最新コンピューティングプラットフォームで、AIや機械学習のワークロードに最適化されたモデルです。

データセンターで必要とされる高い演算能力と効率性を提供し、膨大なデータ処理を高速に行える点が強みです。

NVIDIA B200については以下の記事でも詳しくご紹介しています。

NVIDIA B200とは?概要からスペックまで徹底解説

NVIDIA H200 Tensor Core GPU

NVIDIA H200 Tensor コア GPUは、HBM3eメモリを搭載した初のGPUで大容量かつ高速なメモリを提供し、科学コンピューティングによるHPCワークロードの推進と、生成AIや大規模言語モデル(LLM)の高速化を実現します。Llama 2のようなLLMを処理する際、従来のH100 GPUと比較して推論速度を最大2倍に向上させ、企業がより迅速に洞察を得られるよう支援します。

NVIDIA H100 Tensor Core GPU

NVIDIA H100 Tensor Core GPUはあらゆるデータ センターにかつてない性能、拡張性、セキュリティを提供し、あらゆるワークロードに対応します。H100を搭載したサーバーは、GPUごとに毎秒3テラバイトのメモリ帯域幅を提供し、NVLinkとNVSwitchを使用することで高いスケーラビリティを実現します。これにより、膨大なデータセットに対する高性能なデータ分析が可能になります。

NVIDIA L40 GPU

NVIDIA L40 GPUは、最新世代のRT、Tensor、およびCUDAコアのパワーを活用し、最も厳しいデータセンターワークロードに対して優れたビジュアライゼーションとコンピューティングパフォーマンスを提供します。電力効率に優れたハードウェアとコンポーネントを使用して設計されており、24時間365日のエンタープライズデータセンター運用に最適化されています。

NVIDIA L4 GPU

NVIDIA L4 GPUはビデオ、AI、グラフィックスを効率的に実現します。薄型フォームファクターで設計されたL4は、エッジ、データセンター、クラウドを含むすべてのサーバーにおいて、費用対効果が高く、エネルギー効率に優れたソリューションを実現し、高いスループットと低遅延を提供します。

GPUサーバーに関するよくある質問

ここではGPUサーバーに関するよくある質問をご紹介します。

GPUサーバーは本当にコストに見合いますか?

長期利用や高負荷用途(AI学習、大量解析)であれば、人的コスト削減や処理時間短縮によってTCOを大きく下げられます。

どれくらいのGPUメモリ(VRAM)が必要ですか?

モデルのサイズやデータ量次第ですが、大規模なAIやシミュレーションでは 48~80GBクラス のVRAMを持つGPUが有効です。

クラウド型とオンプレ型、どちらがいいですか?

どちらもメリット・デメリットがあり、用途や求めるセキュリティー要件により変わってきます。例えば短期利用やすぐに利用したい場合、ワークロードの量が変動する場合はクラウドが柔軟で便利です。安定した長期間の利用や動作速度、低レイテンシー、高いセキュリティーを求める場合はオンプレが有利です。

将来的にGPUを追加できますか?

拡張性の高いサーバーを選ぶことで、GPUスロットやメモリ、ストレージの増設が可能です。

まとめ

今回は、GPUサーバーについて、概要や導入するメリット、主な用途などについて詳しく確認してきました。GPUサーバーはPCの処理速度を大幅に拡張させられる設備です。そのため、AI開発や科学研究など幅広い分野で導入が進んでいます。

これからGPUサーバーの導入を行う方には、世界のAI技術をリードするNVIDIA社のGPU製品とSupermicro社のサーバーを組み合わせたGPUサーバーがおすすめです。NVIDIA社のパワフルなGPUシステムは、AI開発や科学研究、3Dレンダリングなどの用途でご活用いただいています。

トゥモロー・ネットでは、NVIDIA社、Supermicro社とのパートナーシップを結んでおり、GPUサーバーを1,000台以上導入してきた実績があります。

Supermicro社 と正規一次代理店トゥモロー・ネットのパートナーシップ

その他にも、AIインフラの選定・設計・構築・保守までを、ワンストップでサポートさせていただきます。GPUサーバーの導入をご検討の方は、ぜひお気軽にお問い合わせください。

Supermicro製 GPUサーバーの特徴や仕様についてはこちら

お問い合わせはこちら

関連記事

クラウドコンピューティングとは?仕組みやメリット・デメリットを解説

GPU導入の落とし穴|データセンターにおける冷却・電力・コスト課題と解決策

【初心者向け】FLOPSとは?GPUサーバーの性能指標を解説

CPUとGPUの違いを徹底比較!処理性能・構造・用途別の選び方をわかりやすく解説

この記事を書いた人

株式会社トゥモロー・ネット

トゥモロー・ネットは「ITをもとに楽しい未来へつなごう」という経営理念のもと、感動や喜びのある、より良い社会へと導く企業を目指し、最先端のテクノロジーとサステナブルなインフラを提供しています。設立以来培ってきたハードウェア・ソフトウェア製造・販売、運用、保守などインフラに関わる豊富な実績と近年注力するAIサービスのコンサルティング、開発、運用、サポートにより、国内システムインテグレーション市場においてユニークなポジションを確立しています。

インフラからAIサービスまで包括的に提供することで、システム全体の柔軟性、ユーザビリティ、コストの最適化、パフォーマンス向上など、お客様の細かなニーズに沿った提案を行っています。