【用途別】GPUサーバー構成の最適解|生成AI・LLM学習/推論向けおすすめモデル【トゥモロー・ネット テックブログ】

生成AIの技術革新に伴い、AIインフラの選定基準も日々変化しています。かつてのような「高性能なGPUを並べれば良い」という単純な図式は崩れ、現在では開発フェーズ(学習、推論、PoC)や扱うモデルの規模に応じた「適材適所」な構成選びが、プロジェクトの投資対効果を左右する時代となりました。

本記事では、現在のAI開発シーンにおいて主流となりつつある3つのユースケースに着目し、それぞれの課題を解決するために推奨される標準的なサーバー構成とその技術的背景を解説します。

目次

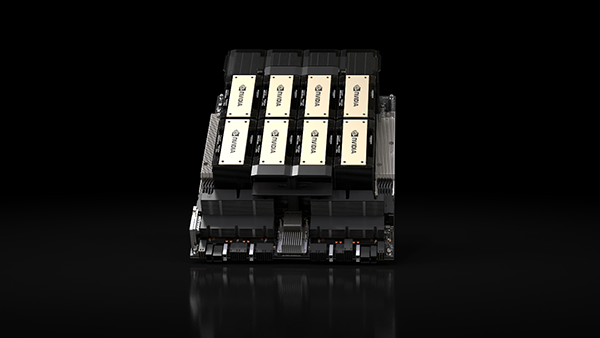

【大規模学習向け】LLM開発の勝敗を分ける「H200 SXM」構成

数千億パラメータクラスの基盤モデル(Foundation Model)開発においては、膨大な計算リソースとメモリ帯域の確保が絶対条件となります。

この領域では、計算時間を物理的に短縮し、開発サイクルを高速化できるハイエンドなフラッグシップ構成が求められるでしょう。ここでは、大規模学習の標準機となりつつあるH200構成の必然性について解説します。

なぜ今、H100ではなく「H200」なのか?メモリ帯域と容量の壁

現在、大規模言語モデル(LLM)の学習において最大のボトルネックとなっているのは、GPUの計算速度そのものよりも「メモリ容量と帯域幅」です。

この課題に対し、NVIDIA H200はH100と比較して約1.8倍となる141GBものメモリ容量を搭載しており、これが巨大モデル開発におけるブレイクスルーとなります。

従来のメモリ容量では、モデルやデータを細かく分割して処理する必要があり、GPU間の通信待ち時間が頻発して学習効率を下げる要因となっていました。しかし、H200の広大なメモリがあれば、より巨大なバッチサイズでの一括処理が可能となり、通信オーバーヘッドを劇的に削減できます。

結果として、学習時間を数週間単位で短縮できる可能性があり、計算リソースのコスト効率を最大化するための論理的な選択肢といえます。

128コアCPUと100GbEで実現する「止まらない学習環境」

GPUサーバーの性能を議論する際、GPU単体のスペックに目が向きがちですが、システム全体のスループットを維持するためには、CPUやネットワークといった「足回り」の強化が不可欠です。どれほど高速なGPUを搭載しても、データの供給が滞れば、GPUは待ち時間(アイドルタイム)で無駄に稼働することになるためです。

そのため、大規模学習用途ではAMD EPYC 9534(64コア×2=128コア)のような多コアCPUを採用し、膨大なデータの前処理やロードを高速化するのがよいでしょう。

また、将来的なマルチノード学習への拡張を見据え、標準で100GbEネットワークを装備することも重要です。計算処理を「止めない」ための強固な足回りを完備することが、ハイエンドGPUの投資対効果を保証する前提条件となります。

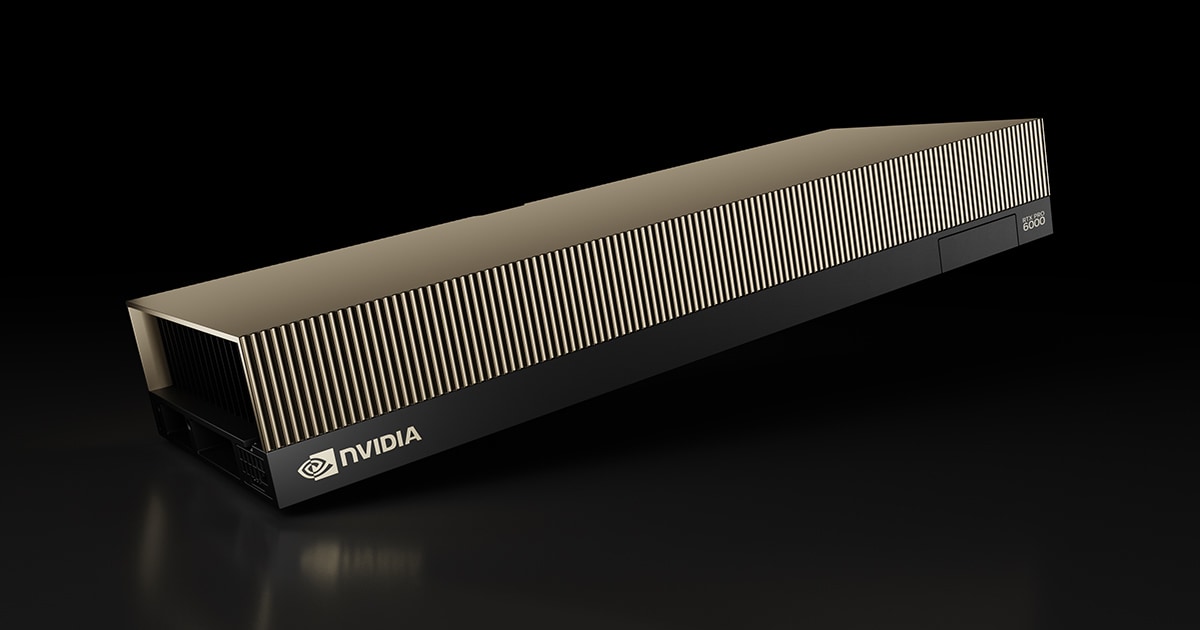

【実用推論・RAG向け】社内AI導入の最適解「RTX PRO 6000 Blackwell」

企業内でのAI活用、特に機密情報を扱うRAG(検索拡張生成)や社内専用LLMの運用においては、「学習」とは異なる要件が求められます。

ここでは最高峰の演算性能よりも、コストパフォーマンスと運用実用性のバランスに優れた、ワークステーションベースの推論環境について解説します。

「学習済みモデル」を最大効率で回すためのVRAM 384GB構成

推論用途のハードウェア選定において、現在のトレンドは「量子化技術」を活用した単体処理です。RTX PRO 6000シリーズはNVLink(GPU間高速通信)に対応していませんが、推論用途であれば必ずしも分散処理が必要ないため、コスト効率の良い選択肢となります。

近年では、70Bクラスのモデルを倍精度で動かすのではなく、4bitや3bitに量子化して軽量化させる手法が一般的です。これにより、GPU1枚でも120Bクラスの超巨大モデルを動作させることが可能になります。

4枚構成であれば、「1枚でチャットボット、別の1枚で要約タスク」といった柔軟な並列稼働が可能となり、用途に応じてリソースを無駄なく使い切ることができます。

データセンターGPUに匹敵する性能を、高コスパで導入する

H100などのデータセンター専用GPUは高額であり、推論用途だけで導入するのはオーバースペックとなる場合があります。一方、RTXシリーズを用いた構成であれば、データセンター機に匹敵するメモリ容量を、より現実的なコストで確保することが可能です。

例えば、合計384GB(構成による)くらいの広大なVRAM領域を確保すれば、複数のRAGシステムや社内AIエージェントを、24時間365日セキュアな社内ネットワーク内で安定して稼働させられます。

クラウドの従量課金を気にせず、定額の資産としてAI環境を使い倒せる点は、実運用フェーズに入った企業にとって大きなメリットとなります。

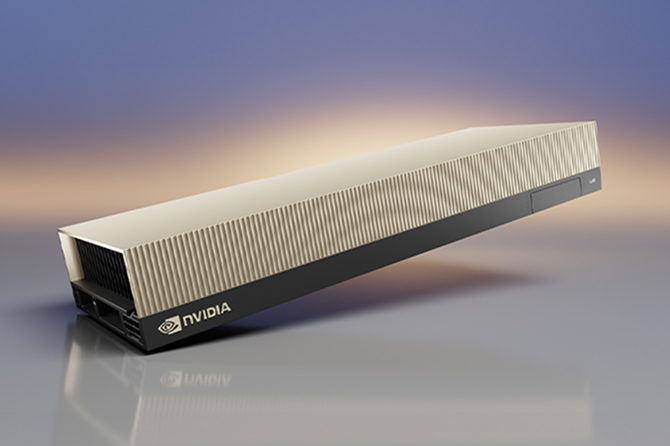

【開発・検証向け】マルチに使える高コスパ機「L40S」モデル

「まずはAI開発環境を整備したい」「画像生成もLLMも試したい」というスタートアップや、企業の部門導入においては、特定の用途に特化しすぎない汎用性が重要です。

ここでは、開発の初期フェーズにおいてリスクを抑えつつ、多様なニーズに応えるエントリーモデルの有用性について解説します。

画像生成から70Bモデル推論まで。迷ったら選ぶべき「万能枠」

NVIDIA L40Sは、AI推論・学習に特化した機能に加え、強力なグラフィックス性能も併せ持つ汎用性の高いGPUです。特にTransformer Engineを搭載しているため、最新の生成AIタスクにおいて高い適性を持っています。

例えば、Stable Diffusionなどの画像生成タスクを高速に処理できる一方で、Llama 3などの70Bクラスの中規模LLMの推論やファインチューニングも快適に行えます。

「何を開発するか詳細まで固まりきっていない」というプロジェクト初期段階において、画像処理からテキスト生成まであらゆる可能性に対応できるL40Sは、開発者にとって手戻りの少ない安全な選択肢となるでしょう。

スモールスタートに最適な5U筐体と拡張性

AIプロジェクトの立ち上げ期においては、初期投資を抑えつつ、将来的な拡張の余地も残した「無駄のない構成」が求められます。

いきなり大規模なサーバーラックを埋めるのはリスクが高いため、取り回しの良い5U筐体などを採用したモデルがスモールスタートには適しています。

まずはPoC(概念実証)や特定部門での先行利用として導入し、成果が出た段階で台数を増やすといった柔軟な運用が可能です。オフィスの一角や小規模なサーバルームでも導入しやすいサイズ感でありながら、本格的なAI開発にも耐えうる性能を持つため、小さく始めて大きく育てるための現実的なインフラ戦略といえます。

失敗しないサーバー選定!スペック比較とインフラ要件

ここまでご紹介した3つの構成を、目的別に比較表として整理しました。自社の現在のフェーズと照らし合わせ、最適なモデルを選定する際の参考にしてください。

【一覧表】学習 vs 推論。目的別・推奨構成マトリクス

| 項目 | 1. 大規模学習向け | 2. AI推論向け | 3. 小規模推論向け |

| GPU | H200 SXM x8 | RTX PRO 6000 x4 | L40S x4 |

| 用途 | 基盤モデル学習 | 高負荷推論 | 一般推論、開発 |

| メモリ | 2.3TB | 768GB | 768GB |

| NW | 100GbE | 10GbE | 10GbE |

意外な落とし穴?「200V電源」と「空調」の必須チェックポイント

高性能なGPUサーバー導入にあたっては、サーバーのスペックだけでなく物理的な設置環境の確認が必須です。導入直前になって「設置できない」というトラブルを防ぐため、以下の要件を必ずご確認ください。

- 電源電圧:全構成で200V環境が必須です(一般的な家庭用100Vコンセントでは動作しません)。

- 電源容量:3000W級の電源ユニットを搭載しているため、十分なアンペア数の確保が必要です。

- ケーブル形状:C19-C20といった高電圧対応ケーブルを使用します。

- 空調設備:GPUサーバーは大量の熱を発します。専用の空調設備や、排熱処理が可能なラック環境が必要です。

3月末までのキャンペーンで「最強のAIインフラ」を手に入れる

本記事でご紹介した構成は、現在実施中の期間限定キャンペーンの対象モデルです。世界的なAIブームにより品薄が続くGPUサーバーですが、NVIDIA Elite Partnerであるトゥモロー・ネットでは、独自の調達ルートにより「優先納期」かつ「特別価格」でのご提供を実現しました。

詳細はキャンペーンページよりお気軽にお問い合わせください。貴社のAIプロジェクトを成功させるための最適な一台をご提案いたします。

お問合せ先

こちらも読まれています

NVIDIA H200とは?NVIDIA H100との違いや最新GPUの導入で得られるメリット

NVIDIA Blackwellとは?H100比で推論30倍、TCOを25倍削減する次世代AI GPU

NVIDIA L40Sとは?その性能や用途についてNVIDIA A100との違いを解説

この記事を書いた人

株式会社トゥモロー・ネット

トゥモロー・ネットは「ITをもとに楽しい未来へつなごう」という経営理念のもと、感動や喜びのある、より良い社会へと導く企業を目指し、最先端のテクノロジーとサステナブルなインフラを提供しています。設立以来培ってきたハードウェア・ソフトウェア製造・販売、運用、保守などインフラに関わる豊富な実績と近年注力するAIサービスのコンサルティング、開発、運用、サポートにより、国内システムインテグレーション市場においてユニークなポジションを確立しています。

インフラからAIサービスまで包括的に提供することで、システム全体の柔軟性、ユーザビリティ、コストの最適化、パフォーマンス向上など、お客様の細かなニーズに沿った提案を行っています。