NVIDIA GPUはなぜAIに最適なのか?選定するポイントも紹介【トゥモロー・ネット テックブログ】

AI開発の現場ではGPUが欠かせない存在になりつつあり、各社のGPUをフル活用して開発やデータ分析に臨む企業が増えています。そのような中で、NVIDIAのGPUはAI開発に最適なツールとして注目され、導入企業数も伸びています。

今回は、NVIDIAのGPUがAI開発に最適とされる理由を解説します。GPU選定時のポイントにも触れるのでご参考ください。

なぜGPUがAI開発に求められるのか

GPU(=Graphics Processing Unit・グラフィックス処理ユニット)がAI開発に必須とされる理由として、並列処理能力の高さが挙げられます。

並列処理能力とは、同時に複数かつ複雑な演算を処理する能力のことであり、性能差はあるもののほとんどのGPUでは平均的に備わっている能力です。大量の行列演算やテンソル演算でもスピーディーに処理することができ、複雑なニューラルネットワーク※の学習・推論に適しています。

※ニューラルネットワークとは、人間の脳の働きや構造を模して学習を行う適応システムのこと

近年はディープラーニングやニューラルネットワークのニーズが拡大しており、GPUを活用した正確でスピーディーな処理が求められるようになりました。AIが必須の時代になりつつある現代においてGPUを活用するシーンが増えています。

GPUがなぜAI開発に必須とされているのかについては、「AI開発にGPUが必要とされる理由とは?選び方のポイントも含めて解説」でより詳しく解説しています。

GPUの進化

GPUは、開発された当初は主に2Dグラフィックス処理の用途に特化していました。その後1990年代後半頃から3Dグラフィックス処理が可能となり、立体的な動きにも対応できるようになったことでゲームや動画制作などで使用されるようになります。

2010年代からは、NVIDIAの「CUDA」などのプログラミングフレームワークを搭載したGPUが発売されたことでさらに利用され始めました。

現在では、機械学習、ディープラーニング、AIによる画像・動画・音声・テキストの生成・科学技術計算等に広く使われるようになっています。

GPUとAI開発の関係

GPUはAI開発の現場で用いられることも多く、もはや必須のプロセッサになりつつあります。

AIの開発現場では、大量の計算をスピーディーに完結させる必要があるため、一般的なCPUだけでは対応できないのが現状です。計算ができたとしても膨大な時間を要したり、正確な数値を算出できないこともあるため、GPUの高性能なプロセッサが欠かせません。

また、ディープラーニングや機械学習に代表されるAIモデルの多くは、大量のパラメーターを持った複雑なネットワーク構造です。膨大な処理を一気に行えるGPUでなければ、他のプロセッサでは不可能と言えるでしょう。

このような状況から、AI開発にはGPUが必須であると言えるのです。

NVIDIAのGPUが多くのAI開発者に支持されている理由

一口にGPUと言ってもさまざまなメーカーの製品がありますが、AI開発に多く利用されているのが「NVIDIAのGPU」です。

NVIDIAのGPUが多くの開発者に支持され業界をリードし続けている理由は、主に以下のようなことが挙げられます。

計算処理能力や処理スピードの高い高性能なGPUだから

NVIDIAはコンピューターグラフィックスや人工知能、ディープラーニング、仮想化技術などを得意としています。GPUの開発・製造・販売を主力にしており、コンピューターゲームやグラフィックス生成などの現場でも導入が広がりました。

「CUDA」の提供によりエンジニアがNVIDIA社のGPUが持つパフォーマンスをフル活用できるから

「CUDA」は Compute Unified Device Architecture の頭文字をとった言葉で、NVIDIA社が開発・提供しているGPU向けの開発プラットフォームです。

CUDAを利用することで、GPUの複数の演算器を利用した高速な並列演算処理をおこなうことができるようになります。

また、C言語、C++、Fortranなどといったプログラミング言語に対応しており、Windows PC(32/64bit)だけでなく、Linux、Macでも利用可能でなこともあり、多くの開発者が利用し高性能なGPUアプリケーションを開発しています。

TensorFlowやPyTorchなどの人気のあるフレームワークをサポートしているから

AI開発に欠かせないライブラリやプラットフォームが整備されているのでより効率的なAI開発が実現します。

GPU製品のラインナップが豊富だから

NVIDIAのGPUはバリエーションが豊富なので、ニーズに合わせて最適な製品を選択可能です。

豊富なバリエーションについて知りたい方はこちらをご覧ください

NVIDIAのGPUの特徴

ここからは、GPUを選定する際のポイントとなるNVIDIA GPUの特徴を解説します。

1.コア

GPUにおける「コア」とは、グラフィックス処理ユニット内部における基本的な演算ユニットを指す用語です。GPUのコアは複数で構成されていることが多く、数が多ければ多いほど高度な計算処理が可能です。

ただ、コアが増えれば増えるほど消費電力も増えるので、発熱による負荷を軽減する対策が必要な点には注意が必要です。

NVIDIAのGPUでは、CUDAコアを主な演算ユニットとして搭載しており、高度なグラフィックス処理や科学技術計算、AIの学習などのワークロードにおいて高い性能を発揮しています。

2.メモリ

GPU選定の際は、メモリ容量や帯域にも注意が必要です。

グラフィック用途でGPUを活用するケースでは、メモリ容量は2GB~24GB程度が一般的なスペックですが、AI開発においてはそれよりも大きなメモリを必要とします。

NVIDIA GPUで例をあげると、「NVIDIA H100 Tensor コア GPU」であれば、メモリは80GBが確保されています。メモリ帯域についても3.35TB/s~7.8TB/sが確保されています。

メモリが大きければ巨大なAIモデルを搭載でき、メモリ帯域が広ければ処理速度が速くなるため、メモリ容量と帯域に優れたNVIDIAのGPUがAI開発者に支持されています。

冷却機能

性能の高いGPUはその分消費電力が大きく、発熱による負荷が生じます。適切な冷却がおこなわれないと熱暴走の発生や性能低下を招き、GPU自体の故障や誤作動につながる恐れがあるため注意が必要です。

NVIDIA GPUでは液冷対応モデルが販売されています。液冷対応のGPUは、カードの背面から冷却用の液体を入れ、直接GPUチップを冷却する構造です。液体の温度が上がると、カードの背面から液体を取り出すようになっています。

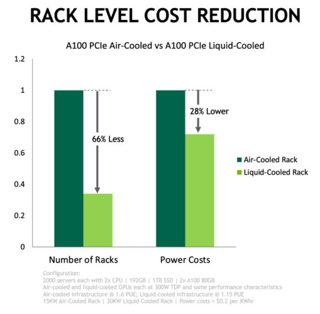

CPU、GPU、ストレージ、ネットワークチップなど多くの「熱源」があるデータセンターでのテストによると、液冷GPUカードは空冷GPUカードに比べ28%の電力コスト削減に成功しています。また、設置面積効率も向上させることができ、ラック数では液冷GPUカードの方が66%も低減できるとされています。

NVIDIA GPU ラインナップ

NVIDIA B200

NVIDIA B200は、AIや機械学習向けに最適化されたGPUでデータセンター向けの最新コンピューティングプラットフォームです。高い演算能力と効率性を備えており、大量のデータ処理やディープラーニングにおいて優れた性能を発揮します。複数のGPUを連携させ、並列処理により、AIモデルの学習を従来よりも高速化する点が大きな特長です。

NVIDIA B200に関する詳細説明はこちら

NVIDIA H200

NVIDIA H200は、革新的なパフォーマンスとメモリ機能を備え、生成AIおよびHPCワークロードを強化します。大容量かつ高速なメモリを提供し、科学コンピューティングによるHPCワークロードの推進と、生成AIや大規模言語モデル(LLM)の高速化を実現します。

NVIDIA HGX H100

NVIDIA HGX H100は、高性能かつ効率的なコンピューティングリソースを提供するプラットフォームです。内蔵のNVIDIA BlueField-3 DPUによってクラウドネットワーキングやセキュリティ、GPUコンピューティングの柔軟性が向上します。

NVIDIA HGX H100製品情報はこちら

NVIDIA H100 NVL

NVIDIA H100 NVLは、最大 700 億パラメーターの LLM (Llama 2 70B) の場合、NVLink ブリッジを持つ PCIe ベースの NVIDIA H100 NVL が、Transformer Engine、NVLink、188GB HBM3 メモリを利用して、あらゆるデータ センターで最適なパフォーマンスと簡便な拡張性を提供し、LLM を主流へと導きます。

NVIDIA H100 NVL製品情報はこちら

NVIDIA H100

NVIDIA H100は、これまでにない性能と拡張性、そしてセキュリティを備え、あらゆるワークロードに対応する高性能GPUです。専用のTransformer Engineによって、兆単位のパラメーターを持つ言語モデルを構築しながら前世代比30倍の高速化を実現します。

NVIDIA H100製品情報はこちら

NVIDIA L40S

NVIDIA L40Sは、強力なAIコンピューティングと業界トップクラスのグラフィックス性能を兼ね備え、AIとグラフィックス両方の分野で突出したパフォーマンスを発揮し、さまざまなワークロードを効率的かつ持続的に高速化します。

NVIDIA L40S製品情報はこちら

NVIDIA L40

NVIDIA L40は、Ada Lovelaceアーキテクチャを採用し、データセンター向けに他に類を見ないビジュアルコンピューティング性能を実現するだけでなく、Root of Trust によるセキュアブート機能を備え、データセンターのセキュリティを一段と強化します。

NVIDIA L40製品情報はこちら

NVIDIA L4

NVIDIA L4は、NVIDIA Ada Lovelaceアーキテクチャを採用しており、ビデオ、グラフィックス、AI、仮想化、ビジュアルコンピューティングなどの分野で、最高水準の性能、耐久性を実現します。

NVIDIA L4製品情報はこちら

まとめ

GPUは今ではAI開発に必須となっています。膨大な演算処理や高速な計算スピードを実現するGPUであれば、AIツールやAIを使ったデータ分析等ができるようになり、ビジネスチャンスを掴むきっかけになるかもしれません。今回はGPUのリーディングカンパニーであるNVIDIA社のGPUがAI開発に適している点について解説してきました。NVIDIA社のGPU製品の革新的な技術と確実な実績がNVIDIA社の評価を高めています。

トゥモロー・ネットがご支援できること

トゥモロー・ネットはNVIDIA GPU製品とSupermicro社サーバーを組み合わせたGPUサーバーを提供しています。これまで1200台以上のGPUサーバーの販売実績があり、構成、構築、保守まで一気通貫でサポートしています。

お問合せについて

NVIDIA製品については是非お気軽にトゥモロー・ネットまでお問合せください。

関連ページ

クラウドコンピューティングとは?仕組みやメリット・デメリットを解説

この記事を書いた人

株式会社トゥモロー・ネット

トゥモロー・ネットは「ITをもとに楽しい未来へつなごう」という経営理念のもと、感動や喜びのある、より良い社会へと導く企業を目指し、最先端のテクノロジーとサステナブルなインフラを提供しています。設立以来培ってきたハードウェア・ソフトウェア製造・販売、運用、保守などインフラに関わる豊富な実績と近年注力するAIサービスのコンサルティング、開発、運用、サポートにより、国内システムインテグレーション市場においてユニークなポジションを確立しています。

インフラからAIサービスまで包括的に提供することで、システム全体の柔軟性、ユーザビリティ、コストの最適化、パフォーマンス向上など、お客様の細かなニーズに沿った提案を行っています。