NVIDIAエンタープライズ向けGPUの種類とスペックを徹底比較

【トゥモロー・ネット テックブログ】

NVIDIAはコンピューターグラフィックスや人工知能(AI)関連のテクノロジーに強い企業であり、特にGPU(グラフィックス処理ユニット)分野におけるリーディングカンパニーとして注目を集めています。

しかし、NVIDIAには複数のエンタープライズ向けGPUがあるため、それぞれのスペックの違いについて把握したい方もいるのではないでしょうか。

本記事では、NVIDIAエンタープライズ向けGPUの種類とスペックについて詳しく解説します。一度に複数の種類を比較したいときにお役立てください。

目次

NVIDIA エンタープライズ向けGPUの種類

早速、ここではNVIDIA エンタープライズ向けGPUの種類を解説します。それぞれのスペックや特徴にも触れるのでチェックしてみましょう。

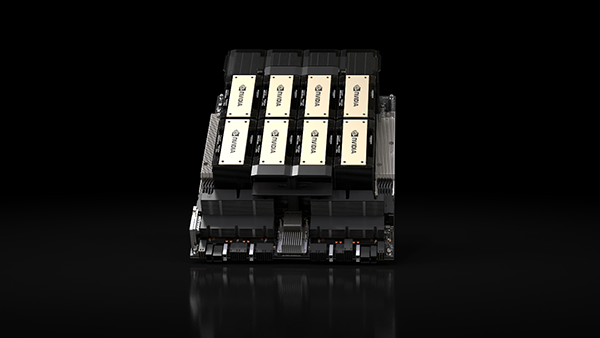

NVIDIA H200 Tensor Core GPU

NVIDIA H200 Tensor Core GPUは、HBM3eを搭載した初のGPUとして有名です。

HPC ワークロードに向けた科学コンピューティングを推進する、大容量かつ高速なメモリも搭載されているのがポイントです。毎秒4.8テラバイト(TB/s)で141ギガバイト(GB)のHBM3eメモリを提供するなど、生成 AI と大規模言語モデル (LLM) の高速化を実現します。

また、NVIDIA H100 Tensor コア GPUの約2倍となる容量を持ち合わせているので、上位互換製品として使ってもよいでしょう。より高速なデータ転送を実現することで、ボトルネックとなる複雑な処理を削減できるのも、NVIDIA H200 Tensor Core GPUならではの魅力です。

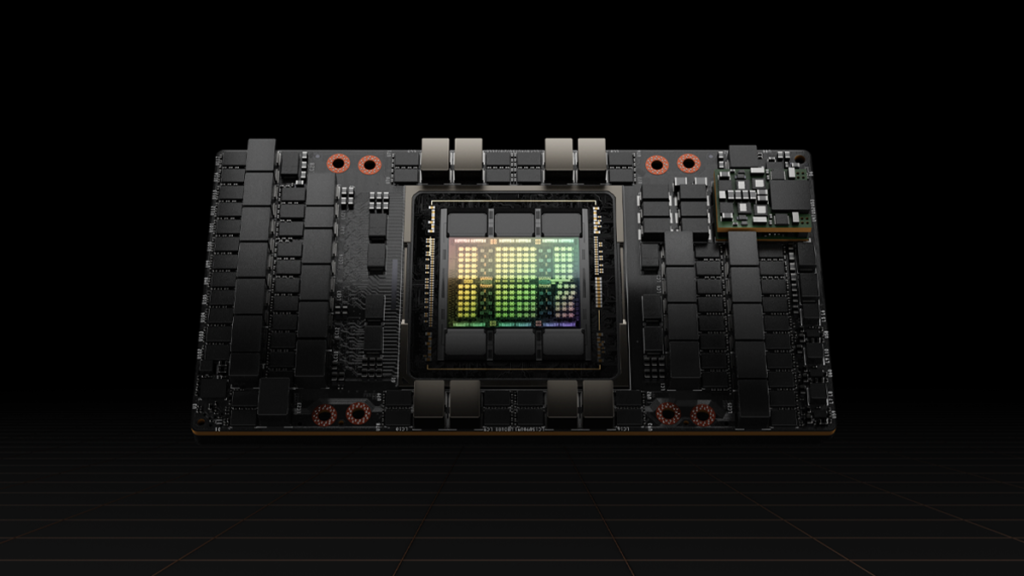

NVIDIA H100 Tensor Core GPU

NVIDIA H100 Tensor Core GPUには「NVIDIA NVLink Switch System」が搭載されており、最大256個のH100を接続できるのがポイントです。エクサスケールのワークロードを高速化でき、兆単位の言語モデルを実装できます。大規模な言語モデルが前世代と比較して30倍も高速化されているので、イノベーティブで便利な対話型AIを実現します。

また、混合エキスパート(MoE)モデルのトレーニングを前世代比最大9倍高速化する「Transformer Engine」を搭載している点にも注目です。GPUとGPUとを毎秒900ギガバイトで相互接続する第4世代「NVLink」もあり、小規模なエンタープライズから大規模な統合 GPU クラスターまで可能です。

NVIDIA A100 Tensor Core GPU

NVIDIA A100 Tensor Core GPUは、2021年にリリースされたGPUであり、前世代(NVIDIA V100)のモデルと比較して最大20倍のパフォーマンス向上に成功しています。NVLinkで2基のNVIDIA A100 GPUを接続することも可能で、160GBという広大なGPUメモリ空間の実現に貢献しています。

単精度・倍精度演算性能の両方を兼ね備えているなどメリットが多く、ディープラーニングやデータサイエンスとの相性も抜群です。大規模な計算を頻繁に実行したいときに使いやすく、マルチGPUシステムの構成を高速化します。

以下の記事では、NVIDIA H100について詳しく説明しております。

NVIDIA H100とは?その性能やおすすめの利用シーンを解説

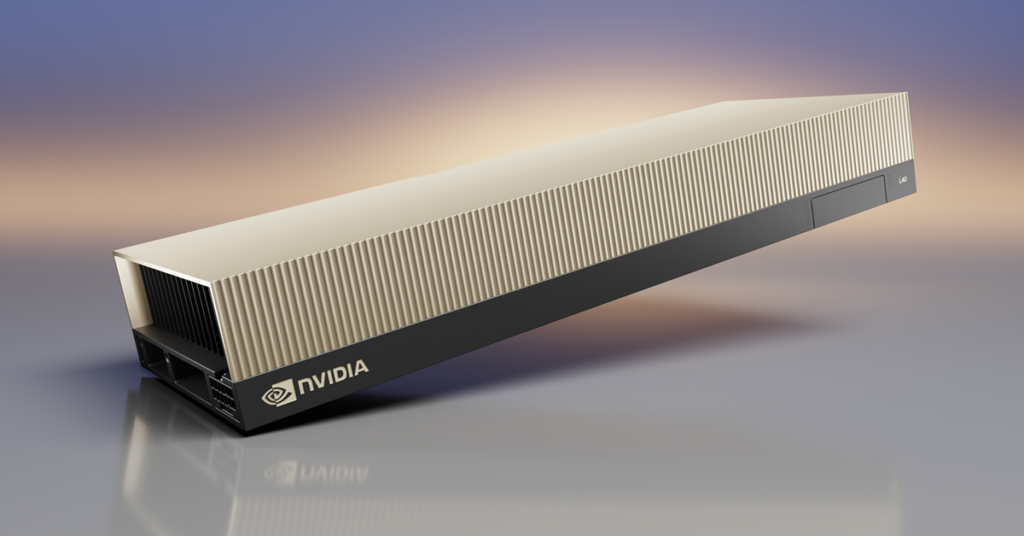

NVIDIA L40S

NVIDIA L40Sは、NVIDIA A100 Tensor Core GPUの推論性能を、最大1.5倍上回るモデルとして2023年8月に発売されました。美しいグラフィックス作成ができるよう最大2倍のリアルタイムレイトレーシング性能も実現しており、パフォーマンスだけでなく効率も向上させます。

また、単精度浮動小数点 (FP32)スループットの高速化と電力効率の向上に役立つCUDAコアを搭載しており、ワークフローでのパフォーマンスが一気に向上しているのもポイントです。3Dモデル開発などに用いやすく、違和感なく動くアニメーションを作成できます。

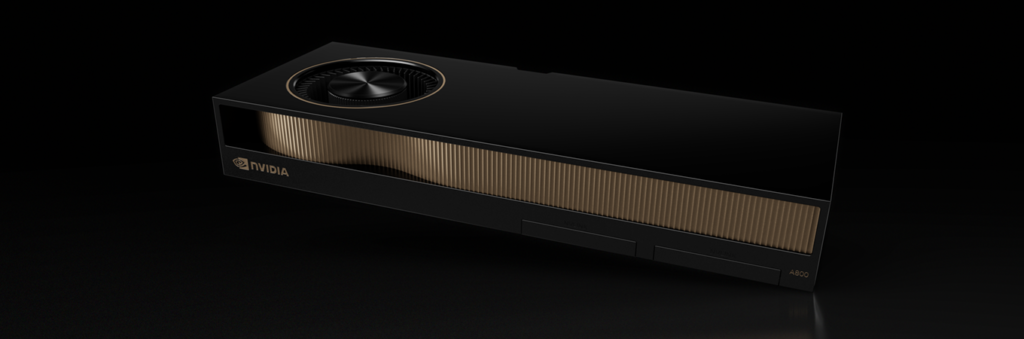

NVIDIA A40 Tensor Core GPU

NVIDIA A40 Tensor Core GPUは、単精度浮動小数点(FP32)演算の倍速処理を可能にする「Ampereアーキテクチャ」を搭載したGPUです。複雑な3Dコンピューター支援設計(CAD)や、コンピューター支援エンジニアリング(CAE)との相性が良く、大規模シミュレーションも可能にします。

CPUメモリからのデータ転送速度を向上させる「PCIE Express Gen 4」も採用されているので、より高速なPCIeパフォーマンスの実現もできるようになりました。ファームウェアの改ざん・破損を防ぐセキュリティも搭載し、安心・安全に利用できます。

NVIDIA A800 40GB Active

NVIDIA A800 40GB Activeは倍精度演算を備えているGPUで、Active(ファン内蔵)のためデスクトップワークステーションで利用できるのがポイントです。

A800 40GB GPUを最大7つの独立したインスタンスに分割し、複数ユーザーがGPUアクセラレーションにアクセスできる「マルチインスタンスGPU(MIG)」機能にも対応しています。「NVIDIA AI Enterprise」のサブスクリプションが最大3年分付属されているなど、メリットも多くなっています。

NVIDIA エンタープライズ向けGPUスペックの比較

下記では、前述したNVIDIA エンタープライズ向けGPUについて、それぞれのスペックを比較表でお伝えします。

| NVIDIA H200 Tensor Core GPU | NVIDIA H100 Tensor Core GPU | NVIDIA A100 Tensor Core GPU | NVIDIA L40S | NVIDIA A40 Tensor Core GPU | NVIDIA A800 40GB Active | NVIDIA Quadro GV100 | |

| FP64 | 34 TFLOPS | 24.0 TFLOPS | 9.7 TFLOPS | - | - | - | - |

| FP64 Tensor コア | 67 TFLOPS | 48.0 TFLOPS | 19.5 TFLOPS | - | - | - | - |

| FP32 | 67 TFLOPS | 48.0 TFLOPS | 19.5 TFLOPS | 91.6 TFLOPS | 90.5 TFLOPS | - | - |

| TF32 Tensor コア(スパース性機能) | 989 TFLOPS² | 400 TFLOPS (800 TFLOPS) | 156 TFLOPS (312 TFLOPS) | 366 TFLOPS | 90.5 TFLOPS (181 TFLOPS) | - | - |

| BFLOAT16 Tensor コア(スパース性機能) | 1,979 TFLOPS² | 800 TFLOPS (1,600 TFLOPS) | 312 TFLOPS (624 TFLOPS) | 733 TFLOPS | 181.0 TFLOPS (362.1 TFLOPS) | - | - |

| FP16 Tensor コア(スパース性機能) | 1,979 TFLOPS² | 800 TFLOPS (1,600 TFLOPS) | 312 TFLOPS (624 TFLOPS) | 733 TFLOPS | 181.0 TFLOPS (362.1 TFLOPS) | - | - |

| FP8 Tensor コア(スパース性機能) | 3,958 TFLOPS² | 1,600 TFOPS (3,200 TFLOPS) | ー | 1,466 TFLOPS | 362 TFLOPS (724 TFLOPS) | ー | ー |

| INT8 Tensor コア(スパース性機能) | 3,958 TFLOPS² | 1,600 TFOPS (3,200 TFLOPS) | 624 TOPS (1,248 TOPS | 1,466 TFLOPS | 362 TFLOPS (724 TFLOPS) | ー | ー |

| 倍精度演算性能 | ー | ー | ー | ー | ー | 9.7 TFLOPS | 7.4 TFLOPS |

| 単精度演算性能 | ー | ー | ー | ー | ー | 19.5 TFLOPS | 14.8 TFLOPS |

| GPUメモリ | 141GB | 80 GB HBM2e | 80 GB HBM2e | 48 GB GDDR6 | 48 GB GDDR6 | 40GB HBM2 ECC | 32 GB HBM2 |

まとめ

NVIDIAエンタープライズ向けGPUは、いずれも高性能なGPUとして知られていますが、利用の際はスペックや特徴を比較しながら用途に合ったものを選定することが重要です。

グラフィックスボードの動作環境、GPUの数、料金などもチェックしながら、満足度の高い製品を選びましょう。

トゥモロー・ネットでご支援できること

トゥモロー・ネットでは、NVIDIAのパートナーとしてGPU製品の販売や導入サポートを実施しています。きめ細やかな提案、構築、導入を提供いたしますので、GPUをお探しの方はぜひお問合せください。さらにトゥモロー・ネットでは、NVIDIA AI Enterpriseの導入サービスをご提供しております。認定サーバーの確認も販売の際にご一緒に確認しておりますので是非お気軽にお問合せください。

お問合せ先

関連ページ

クラウドコンピューティングとは?仕組みやメリット・デメリットを解説

この記事を書いた人

株式会社トゥモロー・ネット クラウドソリューション本部

トゥモロー・ネットは「ITをもとに楽しい未来へつなごう」という経営理念のもと、感動や喜びのある、より良い社会へと導く企業を目指し、最先端のテクノロジーとサステナブルなインフラを提供しています。設立以来培ってきたハードウェア・ソフトウェア製造・販売、運用、保守などインフラに関わる豊富な実績と近年注力するAIサービスのコンサルティング、開発、運用、サポートにより、国内システムインテグレーション市場においてユニークなポジションを確立しています。

インフラからAIサービスまで包括的に提供することで、システム全体の柔軟性、ユーザビリティ、コストの最適化、パフォーマンス向上など、お客様の細かなニーズに沿った提案を行っています。