データセンター向けAMD GPU導入ガイド|ROCmエコシステムと移行の3つの利点【トゥモロー・ネット テックブログ】

データセンターにおけるAIやHPC(高性能計算)の需要が急速に高まる中、GPU選定はシステム全体のパフォーマンスとコスト効率を左右する重要な要素です。

近年、AMDは高性能かつオープンなGPUエコシステムを展開し、NVIDIA一強だった市場に新たな選択肢を提示しています。

本記事では、AMDのGPU導入を検討する企業や技術者に向けて、ROCmエコシステムの特徴や導入メリット、移行時の注意点を詳しく解説します。

目次

AMDのGPUとは?データセンター用途に適した製品ラインアップを解説

AMDのGPUは、AIやHPC(高性能計算)ワークロードの処理に強く、高い並列処理性能と大容量メモリを搭載しているのが特徴です 。AIやHPC分野において、GPUは計算性能と消費電力のバランスが重要です 。

ここでは、AMDが展開するGPUの特徴と、データセンター向け製品のラインアップ、さらにNVIDIA製品との比較までを詳しく解説します。

AMD GPUの特徴|並列処理性能とコストパフォーマンスに優れる理由

AMDのGPUは、並列処理性能とコストパフォーマンスに優れる設計が特徴です。特に、CDNAアーキテクチャによる効率的な演算処理と、大容量のHBMメモリ搭載により、AIやHPC用途での処理能力が向上します。

また、同価格帯のNVIDIA製品と比較してVRAM容量が大きい傾向があり、より多くのデータを一括処理できる点も強みです。結果として、性能あたりのコストが優れ、コスト効率を重視する現場で注目を集めています。

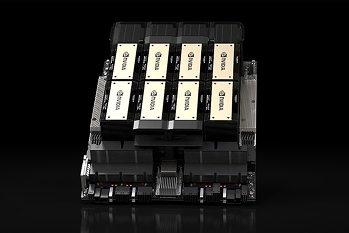

主要製品一覧|Instinct MIシリーズを中心としたハイエンドGPU

AMDのデータセンター向けGPUは、Instinct MIシリーズが中心です。MI300Xは192GBのHBM3を搭載し、大規模AIモデルのトレーニングに最適です。

MI250やMI250XはHPCや科学技術計算に向いており、FP64演算性能にも対応しています。モデルごとに最適化された用途があり、トレーニング、推論、HPCといった目的に応じて選択肢を広く持てる点が魅力です。特に大容量メモリを活かした処理において高い信頼性を発揮します。

NVIDIA GPUとの違いとは?用途別の選定ポイントも紹介

NVIDIAとAMDのGPUの違いは、ソフトウェアエコシステムと価格設計に集約されます。NVIDIAはCUDAを軸に豊富なツールとサポートを提供しており、開発者の利便性が高いのが特徴です。

一方でAMDは、ROCmによるオープンソース開発が可能で、ライセンスの自由度やコストの低さがメリットです。

AIおよびHPCワークロードで特に重要となるメモリ性能を中心に、主要なデータセンター向けGPUのスペックを比較してみましょう。

| 仕様 | AMD Instinct MI300X | NVIDIA H100 (SXM5) | NVIDIA H200 (SXM) |

| メモリ容量 | 192 GB | 80 GB | 141 GB |

| メモリ規格 | HBM3 | HBM3 | HBM3e |

| メモリ帯域幅 (最大) | 5.3 TB/s | 3.35 TB/s | 4.8 TB/s |

| FP64性能 (最大) | 81.7 TFLOPS | 67 TFLOPS | 67 TFLOPS |

表からわかるように、AMD Instinct MI300Xは特にメモリ容量とメモリ帯域幅において、NVIDIAのH100およびH200を上回っています。これは、大規模なAIモデルの学習や、大量のデータを扱うHPCアプリケーションにおいて大きなアドバンテージとなります。

GPUを選定する際には、こうしたスペック上の強みに加え、既存環境との互換性、開発体制、導入予算を総合的に考慮することが不可欠です。

AMD ROCmとは?AI・HPC開発を支えるオープンエコシステムの全貌

ROCmは、GPU計算を支えるAMD独自のソフトウェアスタックで、オープンソースである点が最大の特徴です。

開発者はコードや環境を自由にカスタマイズでき、プロプライエタリな制約を受けません。ドライバ、ランタイム、ライブラリが統合されており、AIや科学技術計算など多用途に対応可能です。

構成の自由度が高く、企業内の独自要件にも柔軟に適応できる点から、特に研究機関や開発現場での導入が進んでいます。継続的なアップデートにより、実用性も着実に向上しています。

PyTorchやTensorFlowとの連携|主要フレームワークとの互換性

ROCmは、PyTorchやTensorFlowなど主要なAIフレームワークに対応しています。PyTorchでは公式サポートがあり、マルチGPUや混合精度の学習も可能です。

TensorFlowもROCm対応のバージョンが公開されており、Docker環境を使えばスムーズな導入が行えます。ただし、対応バージョンや機能に制限があるため、事前に確認しておくことが重要です。

正しく構成すれば、NVIDIAに依存せず高性能なAI開発環境を構築できます。開発コストの抑制と技術的自由度の向上に貢献する選択肢です。さらに、サポート対象は年々拡大しており、フレームワークとの連携精度も着実に改善が進んでいます。

導入前に知っておきたいサポート環境と対応OS

ROCmの導入には、対応するOSやGPUとの組み合わせを正確に把握する必要があります。現在、UbuntuやRHELといったLinuxディストリビューションが公式にサポートされており、長期サポート版が推奨されています。

動作には指定されたカーネルバージョンやGPUが必要であり、すべてのAMD製GPUが対応しているわけではありません。導入前には、AMD公式の互換性リストを参照し、安定動作する構成を確認しておくことが欠かせません。

初期構築では公式Dockerやサンプル環境を活用するとスムーズです。また、ROCmはドライバ更新による環境変化に敏感なため、運用中も継続的なメンテナンスが求められます。

AMD GPUへの移行がもたらす3つの利点

ここでは、AMD製GPUへの移行によって得られる3つのメリットを解説します。

利点① コスト最適化|性能あたりのコストで優位性を発揮

AMD GPUは、導入コストに対する演算性能(Perf/$)と消費電力あたりの性能(Perf/W)で優れた結果を出しています。

例えばInstinct MI300Xは、大容量メモリを搭載しつつ、価格を抑えた構成となっており、NVIDIA製GPUと比較して初期投資額を大きく下げることが可能です。さらに、電力効率が高く、冷却コストや消費電力を含めた運用面の負担も軽減できます。

これにより、長期的なTCO(総所有コスト)を抑えながら、データセンター全体の経済性を高められるでしょう。AIトレーニングやHPCを日常的に扱う現場ほど、この効果は明確に現れます。

利点② 開発の柔軟性向上|独自最適化からの脱却

ROCm(Radeon Open Compute)を基盤とするAMD GPU環境では、開発者がハードウェアに近いレイヤーから環境を制御できるため、従来のCUDA環境にありがちな制限から解放されます。

例えば、低レベルでのチューニングや独自ライブラリの導入、非標準な演算処理の最適化が可能で、研究開発や特殊用途において高い自由度を発揮します。さらに、PyTorchやTensorFlowといった主要なAIフレームワークもROCmに対応しており、既存のコード資産を生かしながらスムーズに移行可能です。

環境構築や開発フローを企業ごとに最適化しやすくなる点も、業務の効率化や開発速度の向上につながります。

利点③ オープンソース活用によるベンダーロック回避

AMDはGPUソフトウェア環境をオープンソースで展開しており、特定ベンダーへの依存を避けた開発が可能です。これにより、将来的にハードウェアを変更したり、新しいクラウド基盤へ移行したりする際にも、ソフトウェア資産をそのまま活用できる柔軟性が確保されます。

また、ROCmは公開仕様に基づいて開発されており、他のツールやミドルウェアとの相互運用性も高く設計されています。特定APIやドライバ仕様に縛られないことは、IT基盤の将来性と独立性を維持するうえで重要な要素です。

自社の戦略や要件に合わせて自由に技術選定できる環境は、変化の速い分野において大きな強みとなるでしょう。

AMD GPUへの移行がもたらす導入時の注意点

AMDが提供するROCmはCUDAとの互換性を一部実現していますが、完全に同じではありません。既存のCUDAベースのコードをAMD環境にそのまま移植できるケースは限られており、特定のAPIやライブラリの置き換え、最適化の見直しが必要になる場面もあります。

また、ROCm対応のソフトウェアは徐々に増えているものの、NVIDIA製品に比べてドキュメントやサポート情報が少ないこともあり、トラブル発生時の調査に時間がかかることがあるでしょう。加えて、ハードウェアとOSの組み合わせによっては動作が不安定になる場合もあるため、導入前にはテスト環境での十分な動作検証が欠かせません。

移行を成功させるには、互換性の確認とチーム内での技術習得も含めた計画的な対応が求められます。

まとめ

AMD GPUの導入は、コスト効率・開発の自由度・将来的な拡張性という観点で大きなメリットがあります。特に、ROCmを活用することで、CUDAに依存しない柔軟な開発環境を構築でき、ベンダーロックも回避可能です。

コストパフォーマンスに優れ、AIやHPC向けの高負荷ワークロードにも対応できる点で、企業のIT戦略にとって有力な選択肢となるでしょう。

AIインフラの構築をご検討の方は、株式会社トゥモロー・ネットが提供する高性能なGPU・サーバー・ストレージ・ネットワークを含めた総合ソリューションをご活用ください。AIに最適化された高性能インフラの構築をワンストップで提供しています。

お問合せ先

関連ページ

【徹底比較】CPUとGPUの違いとは?得意な処理・苦手な処理をわかりやすく解説

GPUメーカーランキング|データセンターインフラ市場について

【初心者向け】AI開発環境の構築ガイド|目的別の手順と推奨ハード・ソフトを紹介

この記事を書いた人

株式会社トゥモロー・ネット

トゥモロー・ネットは「ITをもとに楽しい未来へつなごう」という経営理念のもと、感動や喜びのある、より良い社会へと導く企業を目指し、最先端のテクノロジーとサステナブルなインフラを提供しています。設立以来培ってきたハードウェア・ソフトウェア製造・販売、運用、保守などインフラに関わる豊富な実績と近年注力するAIサービスのコンサルティング、開発、運用、サポートにより、国内システムインテグレーション市場においてユニークなポジションを確立しています。

インフラからAIサービスまで包括的に提供することで、システム全体の柔軟性、ユーザビリティ、コストの最適化、パフォーマンス向上など、お客様の細かなニーズに沿った提案を行っています。