NVIDIA Blackwellとは?H100比で推論30倍、TCOを25倍削減する次世代AI GPU【トゥモロー・ネット テックブログ】

次世代AI処理向けGPUプラットフォームとして登場したNVIDIA Blackwell(ブラックウェル)は、その名称が示す通り、著名な数学者David Blackwellの業績に由来し、H100を凌ぐ推論性能と大幅なTCO(総所有コスト)削減を実現します。

本記事では、Blackwellの概要とアーキテクチャ上の革新点、モデル推論性能や消費電力の改善、各種搭載製品(B200やGB200)、さらに大規模導入時の実例に至るまで、最新情報を整理して分かりやすく解説します。

目次

Blackwellとは?NVIDIAが描く次世代AIプラットフォームの核心

ここでは、Blackwellの仕組みや特徴について解説します。

Blackwellアーキテクチャの特徴と進化のポイント

Blackwellは、NVIDIAが開発した次世代AI向けGPUアーキテクチャで、Hopperの後継として2024年に発表されました。

その名は、統計学とゲーム理論に大きな功績を残した数学者、デイヴィッド・ブラックウェル氏に由来します。Blackwellの設計には6つの主要な革新技術が含まれており、AI処理の高速化と効率化を強力に支えています。

注目すべきは、FP4/FP6精度に対応する第2世代Transformer Engineで、大規模言語モデル(LLM)などの推論処理が格段に高速化されました。さらに、RASエンジンの搭載により、障害予兆検出や運用時の安定性も強化。

解凍エンジンによってGPU内部でのデータ展開速度も大幅に向上し、最大800GB/sの解凍帯域を実現しています。これらに加えて、1.8TB/sの帯域を誇る第5世代NVLinkや、省電力制御によるエネルギー最適化も組み込まれているのが特徴です。Blackwellは性能・信頼性・効率の三要素をバランスよく備えた、AI時代の中核アーキテクチャです。

AIモデル推論性能はH100の30倍|TCOも劇的削減

Blackwellアーキテクチャを搭載したGPUは、AI推論性能においてH100の最大30倍に達するとNVIDIAは発表しています。この飛躍的な性能向上は、FP4演算や新たなメモリアーキテクチャ、高速インターコネクト技術によって実現されました。とくに、Grace CPUとBlackwell GPUを統合した構成では、処理速度とメモリ帯域の両面で効率が大幅に高まります。

代表例として、GB200 NVL72システムはBlackwell GPUを72基、Grace CPUを36基搭載し、最大1.4エクサフロップスのAI処理能力と30TBのメモリ統合空間を備えます。これにより、大規模LLMを一つのGPUのように扱うことが可能となり、従来構成に比べて大幅な性能向上と運用効率を実現しました。

また、同条件下でのTCO(総所有コスト)は従来の25分の1に削減されるという試算もあり、エネルギー消費と設備投資の両方で企業にとって大きなメリットとなっています。Blackwellは、高性能とコスト削減を両立した次世代のAIインフラとしての地位を確立しつつあるといえるでしょう。

クラウドからオンプレまで広がる採用実績と注目度

Blackwellの登場は、クラウドサービスプロバイダーとエンタープライズ市場の双方で大きな反響を呼んでいます。

NVIDIAは、Amazon Web Services(AWS)、Google Cloud、Microsoft Azure、Oracle Cloudといった主要クラウド事業者がBlackwell搭載の新インスタンスを展開すると発表しました。これにより、利用者は従来のクラウド環境のまま次世代AI性能を手軽に享受できるようになります。

一方、オンプレミス環境でもBlackwellの採用は拡大しています。Cisco、HPE、Supermicroなどの主要サーバーメーカーがBlackwell搭載のハードウェア製品を開発・提供しており、企業のAI研究や業務利用への導入が進行中です。

また、AI性能の国際ベンチマーク「MLPerf Inference」でも、Blackwellを搭載したシステムが複数社からエントリーし、競合製品に比べて優れた処理能力を示しました。

このように、Blackwellはクラウドとオンプレミスの両方の領域において急速に普及しており、次世代AIインフラのスタンダードとして、業界の中心的な存在になりつつあります。

Blackwell搭載製品まとめ|注目のB200/GB200とは?

ここでは、Blackwellが搭載されている製品を解説します。

B200 TensorコアGPU

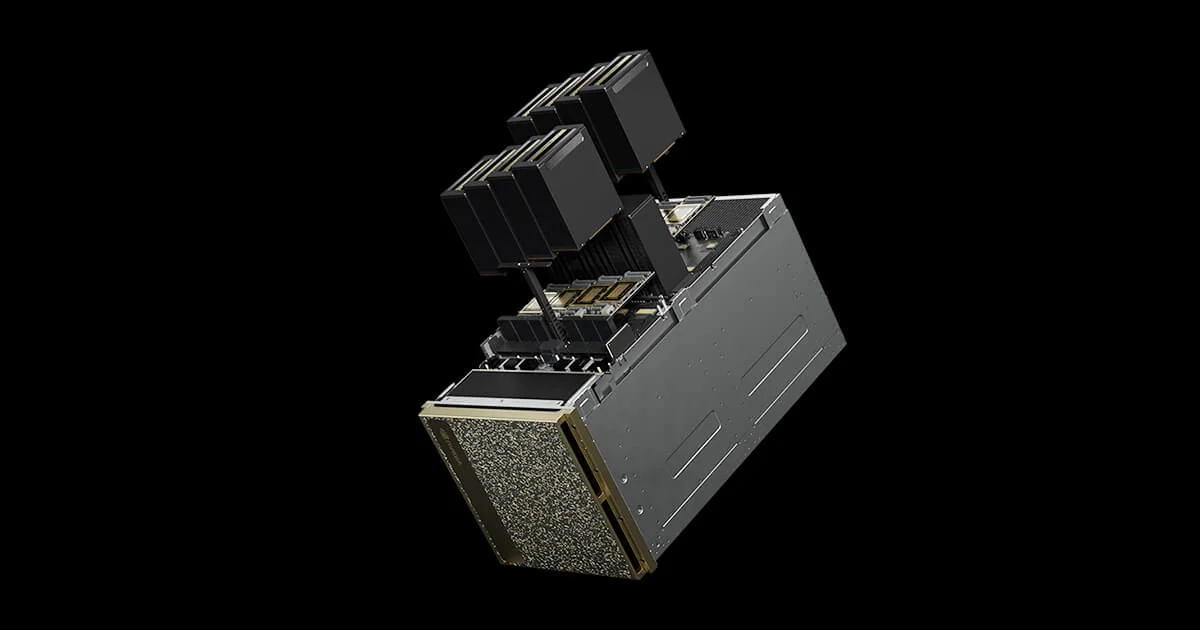

B200は、NVIDIAのBlackwellアーキテクチャを採用した最新のAI向けGPUで、推論処理に最適化された中核モデルです。

2080億のトランジスタを搭載し、第2世代のTransformer EngineによってFP4やFP6の低精度演算に対応しながら、処理の高速化と省電力化を両立しています。さらに、次世代NVLinkは1.8TB/sの帯域を誇り、GPU間の通信遅延を大幅に低減。

HGX B200構成では最大8基のGPUを連携させ、スケーラブルに運用可能です。Supermicroなどからは、これを活用した高密度AIサーバーが提供されており、H100比で最大15倍の推論性能を達成しています。B200は、汎用性と性能のバランスに優れたAI時代の主力GPUといえるでしょう。

GB200 Grace Blackwell Superchip

GB200は、2基のB200 GPUと1基のGrace CPUを高速接続で統合した、NVIDIAの次世代スーパーコンピューティングチップです。この「スーパーチップ」は、最大900GB/sの通信帯域を実現し、CPUとGPUのデータやり取りのボトルネックを解消します。

LLM推論では、H100構成と比べて最大30倍の性能向上、学習では約4倍の効率化が期待されています。Grace CPUは高効率なArmベース設計により、処理性能を維持しつつ消費電力を抑える設計となっており、TCO削減にも貢献するのが特徴です。

GB200は、パフォーマンスと電力効率の両立を求めるAI処理において、極めて実用的かつ先進的な構成です。

NVL72システムとDGX SuperPOD

NVL72は、72基のBlackwell GPUと36基のGrace CPUを1ラックに統合したラックスケールのAIシステムです。1.4エクサフロップスの演算能力と30TBの統合メモリを活かし、大規模LLM推論を1つのGPUのように実行可能にします。

従来のH100構成と比べ、推論性能は最大30倍、TCOは25分の1にまで圧縮されるとされます。さらに、複数のNVL72を連結して構成されるDGX SuperPODは、企業や研究機関向けにスケーラブルなAIインフラを提供。

すでに各国で採用が進んでおり、AI導入を加速する基盤として注目されています。大規模展開を前提に設計されたこのシステムは、次世代のAI運用を支える柱となるでしょう。

まとめ

NVIDIA Blackwellの登場により、AIインフラはさらなる性能向上と省エネルギー化を実現し、業界全体に革新をもたらしています。しかし、その真価を引き出すには、GPUだけでなく、サーバーやストレージ、ネットワークまで含めた全体のインフラ最適化が不可欠です。

株式会社トゥモロー・ネットでは、AI導入における設計・構築・運用支援までを一貫して提供しています。用途に応じた高性能GPUサーバー、堅牢なストレージ、低遅延ネットワークを組み合わせた最適なAI基盤を構築可能です。

詳細なご相談やお見積もりについては、ぜひお気軽にお問い合わせください。

※資料ダウンロード

お問合せ先

関連ページ

NVIDIA B200とは?DGX B200とHGX B200の違いを解説

LLMとGPUの関係とは?LLMに必要なGPUのスペックも解説

NVIDIAエンタープライズ向けGPUの種類とスペックを徹底比較

この記事を書いた人

株式会社トゥモロー・ネット

トゥモロー・ネットは「ITをもとに楽しい未来へつなごう」という経営理念のもと、感動や喜びのある、より良い社会へと導く企業を目指し、最先端のテクノロジーとサステナブルなインフラを提供しています。設立以来培ってきたハードウェア・ソフトウェア製造・販売、運用、保守などインフラに関わる豊富な実績と近年注力するAIサービスのコンサルティング、開発、運用、サポートにより、国内システムインテグレーション市場においてユニークなポジションを確立しています。

インフラからAIサービスまで包括的に提供することで、システム全体の柔軟性、ユーザビリティ、コストの最適化、パフォーマンス向上など、お客様の細かなニーズに沿った提案を行っています。