AIを支える超高速データプラットフォーム

WEKA Data Platformは高速なSDS(Software Defined Storage)ソリューションです。

All NVMeストレージ/高速ネットワーク/専用ドライバーを組み合わせ、NVMeのパフォーマンスを損なうことなく、AIの計算ノードへ最大のスループット性能を提供します。特に大規模なAIのトレーニングや、HPCにおける大量のデータ処理などストレージアクセスがボトルネックになり全体のパフォーマンスに影響する環境で効果を発揮します。

こんな課題を解決

01

高速で大容量なストレージ基盤が必要

一般的に、高速なスループットを提供する専用ストレージは非常に高価です。容量の拡張にも高いコストがかかり、制限がある場合もあります。

02

不要なファイルがストレージを圧迫

高速で高価なストレージであるにも関わらず、データセットやAIモデルの世代バックアップ、ログ、さらには開発者の古い作業ディレクトリーなど優先度の低いデータで容量が圧迫されてしまいます。

03

ファイルの数が非常に多いとスループットが低下

一般的な分散ファイルシステムでは実データは複数ノードに分散されますが、メタデータは限られたノードで管理されます。ファイル数が多いとメタデータ管理ノードに負荷がかかり、パフォーマンスが低下します。

04

将来的に拡張の予定がある

専用ストレージはハードウェアが限定され、拡張性が制限される場合があります。

製品概要

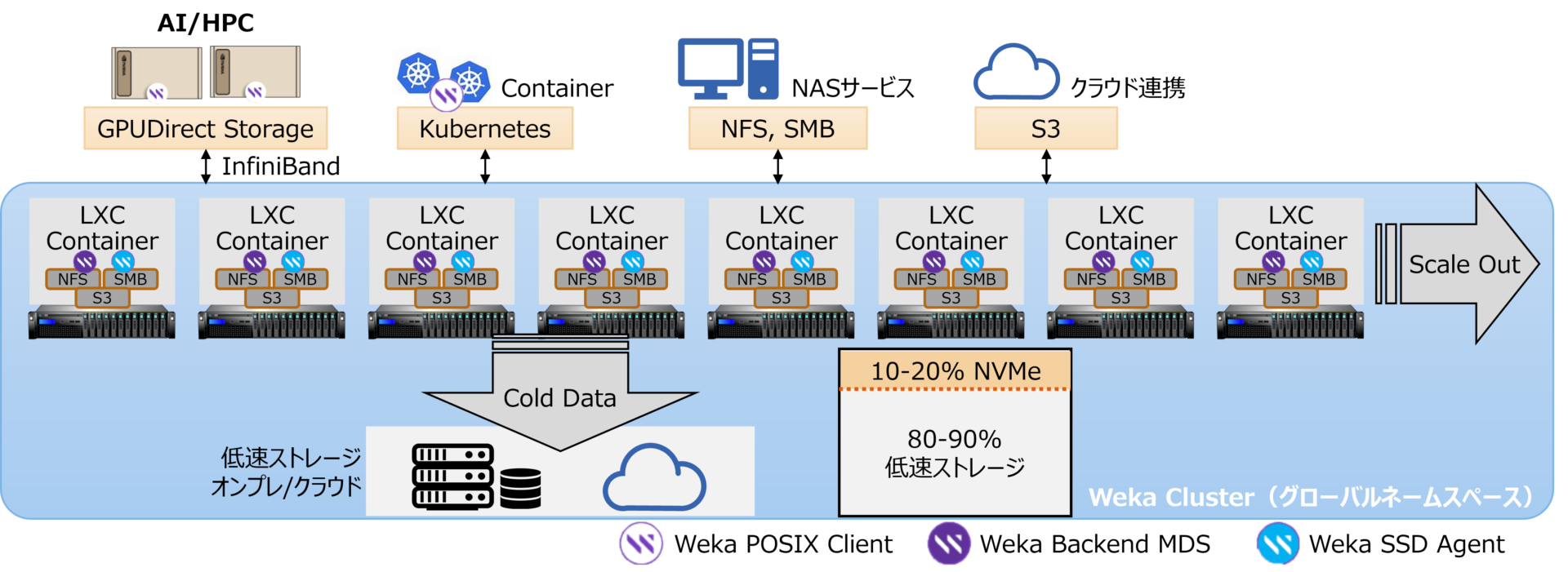

WEKA Data Platformは分散ファイルストレージ・システムです。専用ハードウェアではなく、一般的なx86サーバーにソフトウェアとして構築されます。

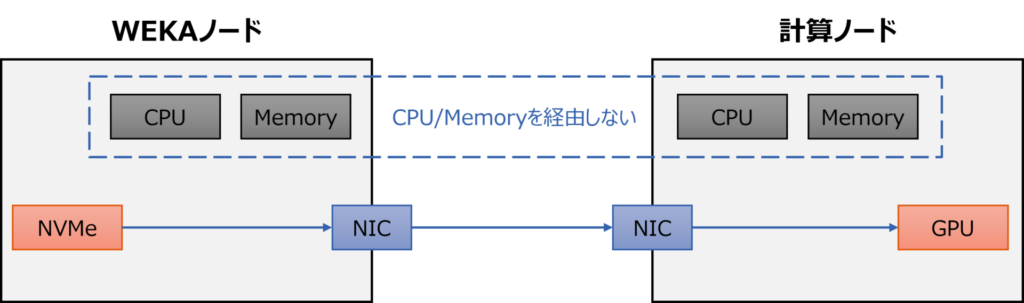

ノードにはすべてNVMeストレージを内蔵し、NVMeのスループットをそのまま計算ノードに提供するために高速なネットワークカードを装着します。専用ドライバーを動作させ、TCP/IPプロトコルをバイパスしてより高速なRDMAやGPUDirect Storageを利用し、オーバーヘッドを最低限に抑えた通信が可能になります。

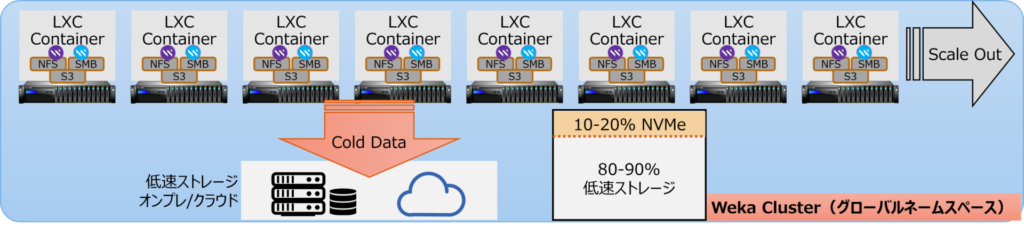

またデータの階層構造により、アクセス頻度の低いCold Dataを自動的に判別し、別の低速ノードに順次移行させる機能を備えることで、貴重な高速ストレージ領域を常に開けておくことが可能です。

製品の特長と利点

01

GPUDirect Storage

専用ドライバーとバリデーションが取れたNICにより、計算ノードへの高速なスループットを実現。CPUやメインメモリーなどのオーバーヘッドを迂回し、NVMeストレージ⇔GPU間で直接データのやり取りを行うことが可能です。

02

アクセス頻度の低いCold Dataを自動退避

データセットやAIモデルの世代バックアップ、ログ、さらには開発者の古い作業ディレクトリーなど優先度の低いデータを判別。データに優先順位(ティアリング)を設定し、優先順位の低いデータは自動的に外部の低速ストレージへ退避します。退避にはS3のプロトコルを利用し、AWSをはじめとしたクラウドへの退避の他、S3に対応しているオンプレストレージも退避先に設定可能です。

さらに退避したデータを見失わないように、WEKAクラスターと退避先をまとめてグローバルネームスペースという単位で管理します。ユーザーがWEKAにアクセスする際は、このグローバルネームスペースがすべて参照可能なため、ユーザーは退避先を意識することなくデータを利用できます。

ユーザーが退避されたデータへのアクセスをリクエストしたときは、WEKAは退避先から自身のWEKAクラスター内のNVMeにデータを戻します。この間ユーザーへのレスポンスが低下しますが、データを戻した後は高速なアクセスが可能になります。

03

メタデータも完全に分散管理

WEKA Data Platformのメタデータは、実データと同様にすべてのノードに分散配置されます。このためスケールアウトで大規模なクラスターを作成しても特定の管理ノードに負荷が集中することが無く、安定したスループットが保たれます。 同様に小さなファイルを大量に扱うことにも適しており、メタデータへの負荷が分散するためスループットがほとんど落ちません。

04

一般的なx86サーバーで構築可能

WEKA Data Platformは専用のハードウェアではなく、一般的なサーバーに構築可能なソフトウェアです。WEKAの認証が取れたサーバー筐体やパーツを選択する必要はありますが、求める性能や予算に応じて幅広い選択肢があります。

製品の活用例

AI/HPCの高速ストレージ基盤

WEKA Data Platformは高速ストレージアクセスのためのSDSソリューションです。高く安定したスループットを実現するためにサーバーパーツにも高い性能を求めます。

大量のデータセットが必要なAIモデルのトレーニング、サイズの大きなAIモデルを頻繁にデプロイする推論サービス、大量のデータを処理するHPC用途に非常に高い効果を発揮します。

製品のよくある質問

WEKAクラスターの最低構成は何ノードからですか?

最低8ノード以上からとなります。

POSIXに対応していますか?

POSIXにも対応しています。

プロトコルは何に対応していますか?

GPUDirect Storage、POSIX、S3、NFS、SMBに対応しています。