Qeek AI Orchestratorとは?

Qeek AI Orchestratorとは、企業規模を問わず簡単に導入することが可能な次世代生成AIシステムです。AIインフラ基盤とAIサービス、そしてこれらの管理機能を搭載し、簡易な操作で全体を把握することができます。

エンタープライズ級のスケーラビリティを備え、企業内の一部門といった小規模の運用から複数の組織に及ぶような大規模利用まで幅広く活用することが可能です。さらに、オンプレミス運用や細かな権限設定などから、企業内の機密情報を堅牢に保護します。

ビジネスの成長に合わせて進化するAI基盤です。

マルチAIエージェントとは

問い合わせから処理手続きまで。

複数のAIエージェントが連携し、

自然な対話で業務をまるごと自動化

CAT.AI マルチAIエージェントは、リードエージェントが司令塔となり、複数のAIエージェントが自律的に連携・判断しながら要件特定に必要な情報収集から手続き処理までを一気通貫で自動化します。

柔軟な対話力と高い処理能力、AIによる自然な会話と通じてユーザーをわかりやすく解決に導くとともに、企業の業務効率化を支援します。

CAT.AI マルチAIエージェントサイト

https://cat-ai.jp/multi-aiagent/

こんな課題を解決

01

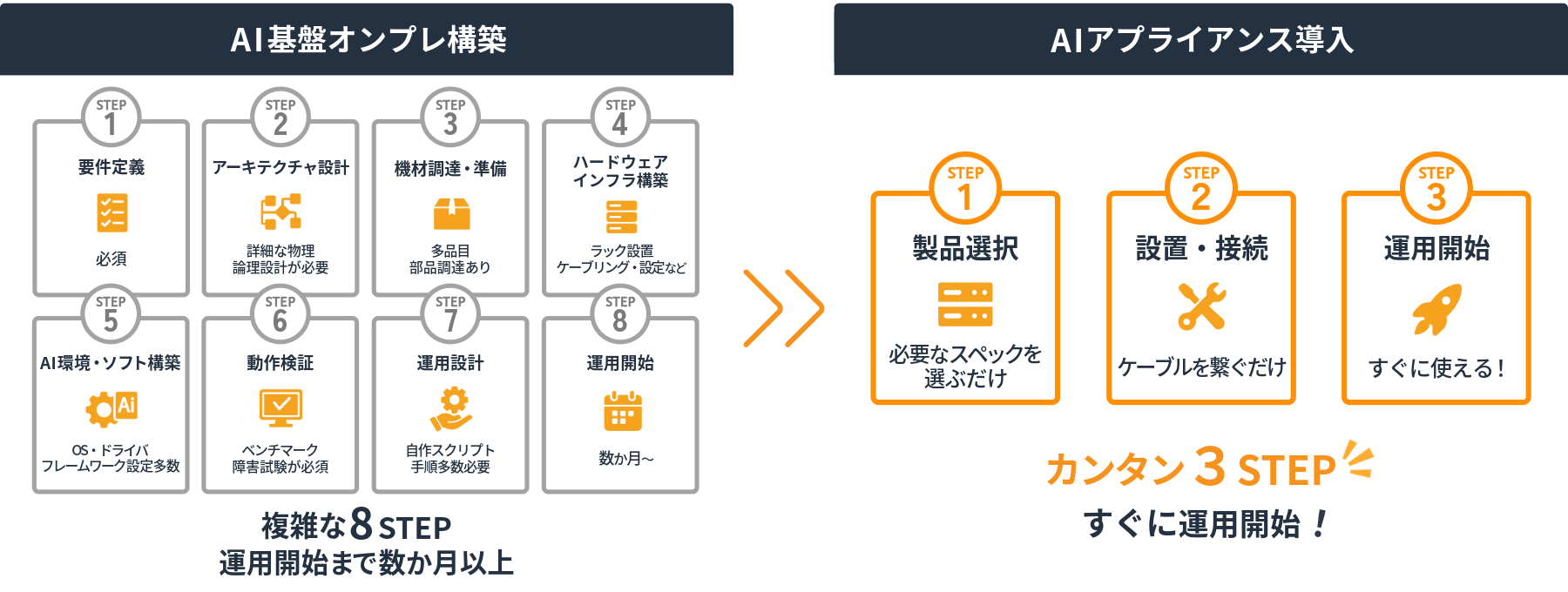

AI基盤の構築・運用における技術的ハードルの高さ

従来のAIシステム導入では、ハードウェア選定・GPUチューニング・クラウド/オンプレ選択・セキュリティ設計など、高度な知識と多大な工数が必要でした。AIアプライアンスは、必要なソフトウェア・ハードウェア・設定を一体化することで、設計・導入・拡張のハードルを大幅に削減し、迅速なAI環境構築を実現します。

02

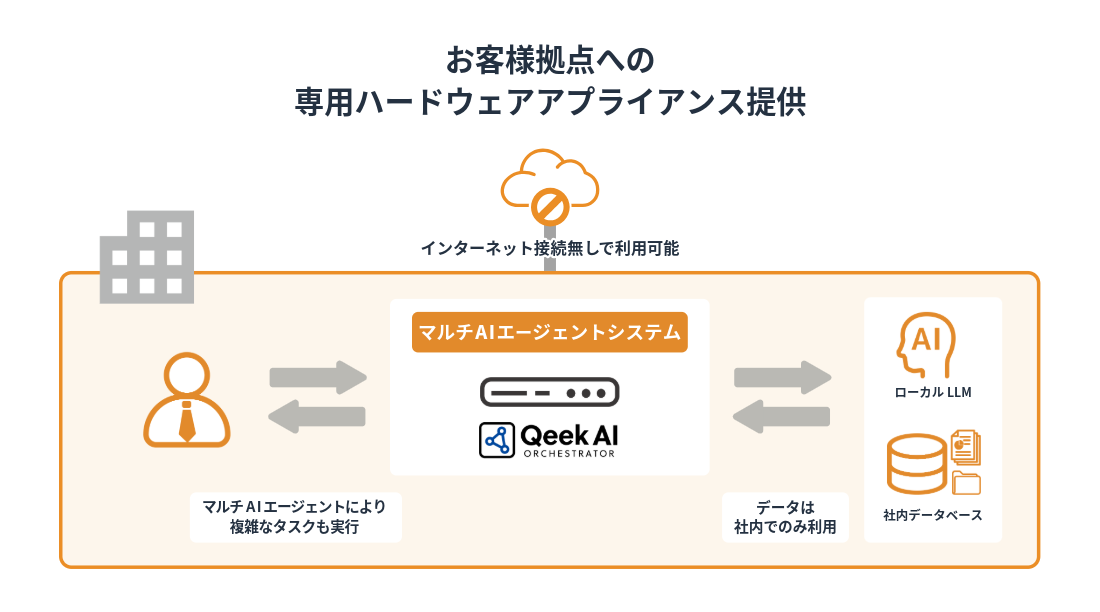

機密情報の外部漏洩リスク

クラウド型AIサービスでは、機密文書・社外秘データを外部環境にアップロードせざるを得ず、情報漏洩やコンプライアンス違反のリスクが伴います。AIアプライアンスはオンプレミスまたは閉域ネットワーク内での運用が可能で、社内の機密情報を安全に処理・活用できます。

03

社内に蓄積された非構造データの再活用が困難

社内のPDF、議事録、マニュアルなどの非構造データが活用されずに眠っている企業は少なくありません。マルチAIエージェントが役割分担し、検索、要約、分類などを自動化。RAGやLLMとの連携により、社内データを実用的な知識として再活用できる環境を実現します。

04

生成AI導入への技術的不安と初期コスト

ChatGPTなどの生成AIには関心があるが、「どう始めたらいいかわからない」「クラウド課金が不安」「内部展開が難しい」といった声は多くあります。AIアプライアンスは、導入・運用・管理を簡素化し、あらかじめチューニングされたLLMや管理機能を搭載。社内PoCやスモールスタートが容易で、生成AI活用への第一歩を安全に踏み出せます。

Qeek AI Orchestratorの特長と利点

01

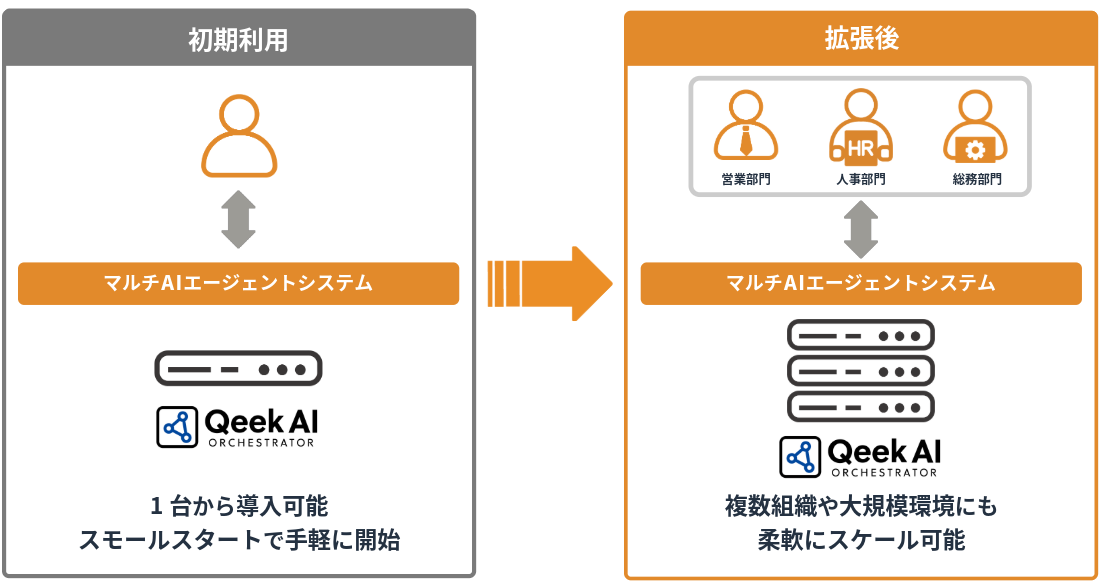

エンタープライズレベルの拡張性・スケーラビリティ

Qeek AI Orchestratorは1台から導入可能で、簡単に拡張することができるため、様々な規模で利用できます。

一部署での利用を想定して1台から導入した場合でも、サーバーを増設することで、複数の組織や大規模サービスに利用拡大することが可能です。

02

オンプレミス導入で企業内の情報をセキュアに保護

オンプレミスのGPU搭載モデルは、外部に社内データやトランザクションを一切公開する必要が無く、データを安全な社内ネットワークでのみ利用することができます。

また、データの利用権限やアクセス権限も細かく設定できるため、「一定以上の役職者のみ閲覧を許可したい」「特定の部門のみで利用したい」といったニーズにも対応可能で、会社内の資産をより有効に活用することができます。

03

導入まで3STEP 複雑な設計は不要

従来のAIシステムでは要件定義や各種設定、構築、動作検証など多くの段階を踏む必要があり、運用開始まで数ヶ月を要していました。Qeek AI Orchestratorは用途や規模に応じてあらかじめパッケージにしているため、必要なステップは3つのみ、すぐに運用開始可能です。

簡単な初期設定で購入後すぐに利用開始可能

AI運用に必要なものはすべて揃えた状態でお届けするので、IPやサーバー設定などの一般的なインフラ設定と管理者Webサイトからの利用設定をするだけで運用開始することができます。

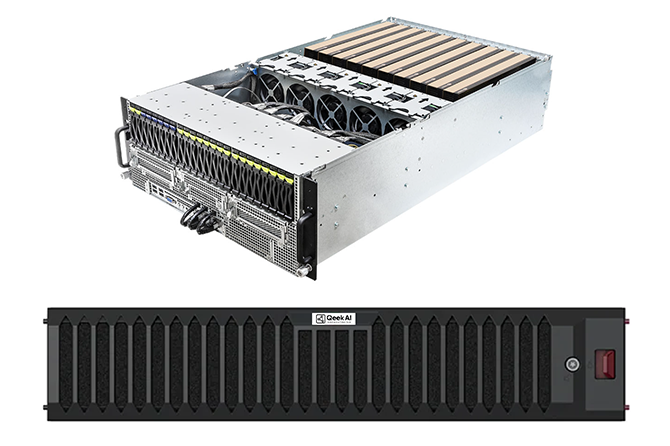

QeeK AI Orchestrator製品スペック一覧

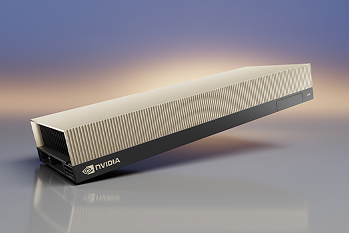

Qeek AI Orchestrator スターターモデル

クラウド上の大規模言語モデル (LLM) を活用することで、初期コストを抑えて迅速に導入可能。まずはスモールスタートでAI活用を始めたい企業に最適なモデルです。

| 仕様 | 数量 | 補足 | |

|---|---|---|---|

| System | 1U rackmount | 1 | |

| CPU | Intel Xeon 4510 12Core 2.4Ghz | 2 | |

| Memory | DDR5-5600 ECC REG DIMM 64GB | 4 | |

| Storage | 2.5“ SSD SATA 960GB (OS領域) | 2 | ハードウェア RAID 1 |

| 2.5“ SSD SATA 7.68TB (データ領域) | 4 | ハードウェア RAID 10 | |

| NIC | 2port Intel X710-AT2 10GbE RJ45 | 1 | |

| Power Supply | 860W Redundant Titanium Level Hot-plug power supplies | 1 |

Qeek AI Orchestrator スタンダードモデル

GPU搭載アプライアンスにより、社内データの活用と保護を両立。高セキュリティかつ安定したAI処理環境を構築したい企業に適したモデルです。

| 仕様 | 数量 | 補足 | |

|---|---|---|---|

| System | 4U rackmount | 1 | |

| CPU | Intel Xeon 6530P 32Core (2.3/2.8GHz) | 2 | |

| Memory | DDR5-5600 ECC REG DIMM 64GB | 16 | |

| Storage | 2.5“ PM893 SATA SSD 960GB (OS領域) | 2 | ハードウェア RAID 1 |

| 2.5“ SSD SATA 7.68TB (データ領域) | 4 | ハードウェア RAID 10 | |

| NIC | 4port Intel XL710+ X557 10GbE / RJ45 AOC | 1 | |

| 2port Intel i350 1GbE / RJ45 onboard | 1 | ||

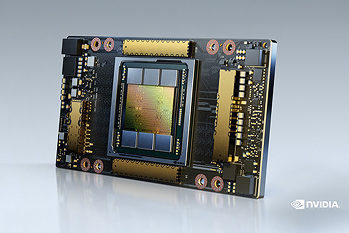

| GPU | NVIDIA RTX PRO 6000 Server Edition 96GB | 2 | |

| Power Supply | 3+1, 80-PLUS Titanium, 3200W | 1 |

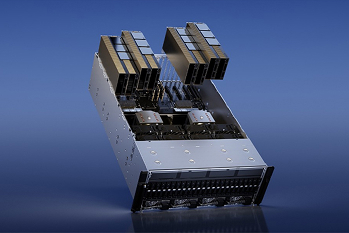

Qeek AI Orchestrator スケールモデル

高性能GPUサーバーによる柔軟なスケールアウト構成で、大量データ処理や高度なAIワークロードにも対応。全社規模での本格展開に最適なモデルです。

Kubernetes Control Plane Nodes + Ceph Storage

| 仕様 | 数量 | 補足 | |

|---|---|---|---|

| System | 2U rackmount | 1 | |

| 1ノードあたりの仕様 (4ノード マルチノードアーキテクチャ) | |||

| CPU | Intel Xeon 6530 32Core 2.1GHz | 2 | |

| Memory | DDR5-5600 ECC REG DIMM 64GB | 8 | |

| Storage | M.2“ NVMe 960GB (OS 領域) | 2 | ハードウェア RAID 1 |

| 2.5“ U.2 NVMe 7.68TB (データ領域) | 6 | Ceph OSD | |

| NIC | 4port Intel E810-CAM1 25GbE / SFP28 AIOM | 1 | |

| 4port Inte XL710-BM1 10GbE / RJ45 AOC | 1 | ||

| Power Supply | 3000W Redundant Titanium Level power supplies | 1 |

GPU Worker Nodes

| 仕様 | 数量 | 補足 | |

|---|---|---|---|

| System | 4U rackmount | 1 | |

| CPU | Intel Xeon 6530P 32Core (2.3/2.8GHz) | 2 | |

| Memory | DDR5-5600 ECC REG DIMM 64GB | 16 | |

| Storage | 2.5“ PM893 SATA SSD 960GB (OS領域) | 2 | ハードウェア RAID 1 |

| NIC | 4port Intel E810-CAM1 25GbE / SFP28 AOC | 1 | |

| 4port Intel XL710+ X557 10GbE / RJ45 AOC | 1 | ||

| 2port Intel i350 1GbE / RJ45 onboard | 1 | ||

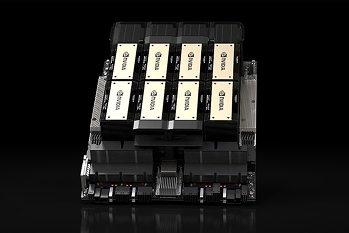

| GPU | NVIDIA H200NVL 141GB | 8 | |

| GPU Option | NVLINK Bridge Board Hopper GPU 4way Passive | 2 | |

| Power Supply | 3+1, 80-PLUS Titanium, 3200W | 1 |

カタログのダウンロードはこちらから

製品のよくある質問

インターネットに接続しないオフラインでもAIを利用できますか?

スターターモデル以外は完全オフラインでの利用を想定しており、インターネット接続を必要とせずLANのみでAIを利用可能です。

スターターモデルについてはGPUを内蔵しないアプライアンスのため、外部のAI(ChatGPTなど)と連携して動作しますのでインターネット接続が必要です。

各モデルの違いは何ですか?

スターターモデルはGPUを搭載しないことにより安価で導入可能なモデルです。

スタンダードモデルは内部にGPUを搭載し、インターネットに接続せず機微な情報もAIで利活用することができるモデルです。

スケールモデルはGPUモデルの特長に加えて高性能なGPUを搭載し、GPUサーバーを追加(スケールアウト)することでさらに大規模な利用にも対応するモデルです。

サーバーはどこに設置すればいいですか?

すべてラックマウント型のサーバーで構成されているため、設置にはサーバーラックが必要です。そのため社内のサーバールームや、ハウジングデータセンターへの設置が必要となります。

ネットワークスイッチはどうすればいいですか?

スターターモデル、スタンダードモデルについては特別なネットワークスイッチが必要ないため、既存のネットワークスイッチに接続すれば利用可能です。もし追加で必要であれば当社からご案内することも可能です。

スケールモデルは高速なネットワークが必要になるため、基本的に当社からご案内いたします。