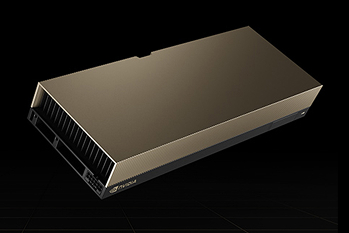

NVIDIA HGX B200とは?

AI とハイパフォーマンス コンピューティング向けに開発

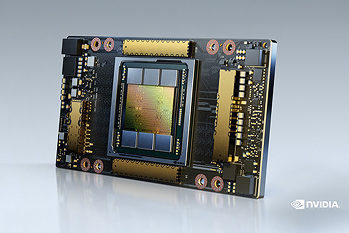

NVIDIA HGX B200 は、Blackwell世代のB200 GPUを搭載可能なモジュラー型GPUプラットフォームであり、大規模言語モデルの学習からリアルタイム推論、さらには分子シミュレーションや自動運転開発といったHPC分野まで、幅広い用途に対応します。従来世代比で推論性能は15倍、消費電力とTCOは1/12と効率性にも優れ、液冷・空冷やMIGによる柔軟なシステム構成でデータセンター環境に最適化。AI時代の研究・産業・サービスを支えます。

製品の特長と利点

01

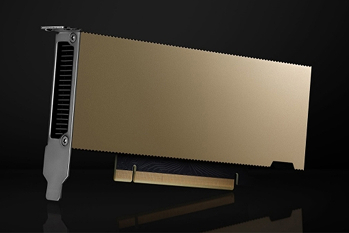

最新Blackwell GPUを8基搭載

NVIDIAの最新アーキテクチャ「Blackwell」を採用したGPUを8基搭載し、圧倒的な並列処理性能を提供します。これにより、これまで数百台規模のクラスタで必要だった計算タスクも、よりコンパクトに実行可能です。

AIモデルのトレーニングやHPCワークロードに最適化され、最新世代の計算ニーズに応える設計となっています。学習速度の向上だけでなく、柔軟な拡張性も備えており、次世代データセンターの最適なGPUです。

02

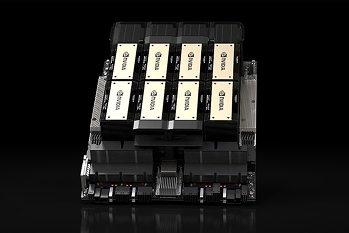

最大1.4TBのGPUメモリ

1GPUあたりの大容量HBM3eを組み合わせることで、合計最大1.4TBものメモリを利用可能。これにより、数千億〜兆規模のパラメータを持つ大規模言語モデルも、効率的に学習・推論を行えます。メモリ帯域も大幅に強化されており、大量のデータを処理しながらもスループットを落とさない設計です。結果として、学習効率の改善やモデルサイズの制約を大幅に軽減します。

03

GPU間通信14.4TB/sのNVLink/NVSwitch

第5世代のNVLinkとNVSwitchを搭載し、GPU同士を合計14.4TB/sで接続。複数GPUを1つの巨大なプロセッサのように扱うことが可能となります。これにより、分散学習における通信の遅延やボトルネックを最小化し、効率的なスケールアップを実現します。

特に、大規模AIの学習やHPCにおいてはGPU間の高速通信が成果を左右するため、この性能強化は大きなメリットとなります。

04

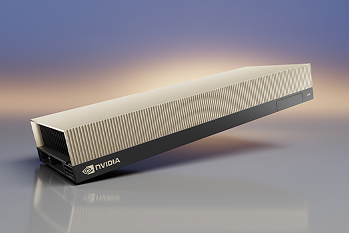

推論性能15倍・TCO 1/12の効率性

HGX B200は従来世代と比較して推論性能が最大15倍に向上しながら、消費電力とTCOを1/12に削減。性能強化と同時に省エネ性を両立し、データセンター運用におけるコストパフォーマンスを飛躍的に改善します。

クラウドサービス事業者や研究機関は、短期間での成果獲得と長期的なコスト削減の両立が可能となります。サステナブルなIT基盤としての価値も高く、環境負荷低減に貢献します。

05

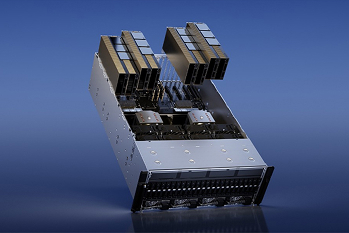

柔軟なシステム構成

液冷と空冷の両方に対応しており、設置環境や運用方針に応じた柔軟な構成が可能です。

また、MIG(Multi-Instance GPU)機能により、1つのGPUを最大7つに分割することで複数のワークロードを並行して処理できるため、

大規模AIの学習環境から中小規模の推論サービスまで幅広く対応でき、リソースの効率利用を実現。異なる用途や規模感にフィットする拡張性が魅力です。

06

幅広い活用領域と実証済みの性能

1GPUあたり最大18 PFLOPS(FP4)、8GPU構成で合計144 PFLOPSという演算性能を誇り、生成AIやマルチモーダルAIの推論処理はもちろん、分子動力学や気象予測のような科学シミュレーションにも対応可能です。これにより、AIとHPCを横断的にサポートするプラットフォームとしての役割を担います。

製品の活用例

計算シミュレーション

HGX B200は高い演算性能で流体解析や構造解析を高速化。自動車や航空宇宙分野の設計・検証を効率的に支援します。

AIトレーニングと推論

最新アーキテクチャと大容量メモリにより大規模AIモデルの学習と推論を加速し、生成AIやLLM開発に最適です。

データ処理分析

膨大なデータの並列処理を実現し、金融・医療・科学研究などでリアルタイム解析や高度なデータ活用を可能にします。

製品スペック

| スペック詳細 | |

|---|---|

| フォーム ファクター | 8x NVIDIA Blackwell SXM |

| FP4 Tensor コア** | 144 PFLOPS | 72 PFLOPS |

| FP8/FP6 Tensor コア* | 72 PFLOPS |

| INT8 Tensor コア* | 72 PFLOPS |

| FP16/BF16 Tensor コア* | 36 PFLOPS |

| TF32 Tensor コア* | 18 PFLOPS |

| FP32 | 600 TFLOPS |

| FP64/FP64 Tensor コア | 296 TFLOPS |

| メモリ合計 | 1.4TB |

| NVLink | 第 5 世代 |

| NVIDIA NVSwitch™ の特長 | NVLink 5 スイッチ |

| NVSwitch GPU から GPU への帯域幅 | 1.8TB/秒 |

| 合計 NVLink 帯域幅 | 14.4TB/秒 |

*疎性あり

**スパース性あり |スパース性なし

製品のよくある質問

GPUサーバーはNVIDIA認定を受けていますか?

はい。NVIDIA認定済みのGPUサーバーを提供しています。

サーバーのサイジングに協力していただくことは可能ですか?

はい。用途や希望スペック、ご予算などをヒアリングさせていただき、最適なものを提案いたします。

スペックの細かなカスタマイズは可能ですか?

はい。ご希望があればCPU、メモリー、ストレージ、ネットワークなどを細かくカスタマイズ可能です。サーバー本体や搭載するGPUにより推奨構成があるため、まずはご希望をお伺いさせていただきながらご提案いたします。

価格について教えてください。

構成に応じてパーツが変わるため都度お見積りいたします。ご相談ください。

GPUDirect RDMAは利用できますか?

GPUDirect RDMAを利用可能なサーバーもございます。必要要件がありますのでまずはご希望などをお聞かせください。

なぜB200を選ぶべきですか?

推論性能が最大15倍、TCOが1/12になるなど、高性能と省電力性を両立しています。

冷却方式の選択肢はありますか?

空冷・液冷の両方に対応し、環境に合わせて選べます。

H100/H200と比べて性能差は何ですか?

推論性能が最大15倍向上するなど、性能・効率ともに大幅に進化しています。

既存のAI環境と混在構成は可能ですか?

はい。既存のGPUサーバー(H100/H200など)との混在構成も可能ですが、最適化が必要な場合があります。環境に合わせて設計します。

GPUクラスタ構成は可能ですか?

複数台のHGX B200を組み合わせてGPUクラスターを構築できます。

初期導入支援はありますか?

はい。選定〜設置〜初期設定まで一貫してサポート可能です。

HGX B200の導入でTCO削減は期待できますか?

省電力化と性能向上により、長期運用でコスト削減が見込めます。

HGX B200はどのサーバーベンダーに対応していますか?

Supermicro など複数のOEMに対応し、要件に合わせて選定できます。

パートナー

保証・サポート

導入時のサポート

HW選定のご相談から組み立て、ラッキングまでサポートいたします。 ご要望によりOS導入・初期設定・各種ソリューションの構築も対応可能です。 記載の無い要件であっても対応可能なケースがございます。